Intelligence Artificielle

Investir dans le matériel d'IA : des processeurs aux unités centrales de traitement (XPU)

Securities.io applique des normes éditoriales rigoureuses et peut percevoir une rémunération pour les liens vérifiés. Nous ne sommes pas un conseiller en investissement agréé et ceci ne constitue pas un conseil en investissement. Veuillez consulter notre divulgation de l'affiliation.

Investir dans le matériel d'IA : une approche à la pelle et à la pioche

L’IA promet d’être le changement le plus important dans notre économie, nos systèmes productifs et notre société au cours des dernières décennies, rendant potentiellement même les changements radicaux apportés par Internet triviaux en comparaison.

Cela pourrait entraîner la disparition d'une catégorie entière d'emplois, notamment ceux de chauffeurs, de traducteurs, de support client, de concepteurs de sites Web, etc. D'autres emplois pourraient connaître une réduction radicale de la demande, comme les programmeurs, les avocats débutants, les diagnosticiens, etc.

Cela devrait également créer beaucoup de valeur ajoutée et de productivité pour de nombreuses autres tâches, les sociétés de logiciels d’IA dominantes étant probablement les premières à atteindre des capitalisations boursières auparavant inimaginables.

Pour toutes ces raisons, les marchés financiers et les investisseurs ont été fascinés par l'IA et accordent une grande attention aux progrès des nombreux géants de la technologie dans l'IA, ainsi qu'à la forte concurrence émergeant des géants technologiques chinois comme Alibaba et des startups comme Recherche profonde.

Une autre façon de profiter de l'essor de l'IA est d'adopter la stratégie éprouvée lors de chaque ruée vers l'or : ne pas chercher de l'or, mais vendre des pioches et des pelles. Cette stratégie a certainement fonctionné pour les entreprises les mieux placées pour vendre du matériel optimisé pour l'IA, notamment Nvidia (NVDA -0.55%) ayant transformé ses cartes graphiques de jeu en puces d'entraînement à l'IA, ce qui en fait l'entreprise la plus valorisée au monde, ayant dépassé l'étonnante capitalisation boursière de 4 XNUMX milliards de dollars (suivez le lien pour un rapport complet sur Nvidia).

Parce que l’IA nécessite un matériel très spécifique, généralement différent des autres formes précédentes de tâches informatiques, et qu’elle représente une opportunité commerciale considérable, l’industrie des semi-conducteurs est désormais dans une course pour développer de nouvelles formes de matériel conçues spécifiquement pour la formation et l’exécution de programmes d’IA.

Même si Nvidia devrait rester l’une des principales entreprises du secteur, des alternatives émergent désormais et pourraient offrir des opportunités intéressantes aux investisseurs qui y prêtent attention tôt.

Pourquoi l'IA a besoin de matériel spécialisé

De nombreux petits calculs

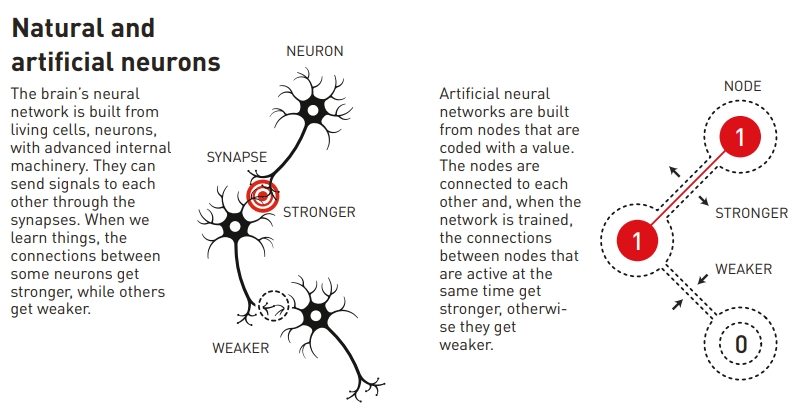

Les premiers efforts en IA utilisaient la même capacité de calcul que les autres programmes, se concentrant principalement sur les processeurs (unité centrale de traitement – CPU). Les CPU restent importants, mais il est rapidement apparu qu'ils n'étaient pas optimaux pour la plupart des méthodes utilisées actuellement pour développer des IA.

Les réseaux neuronaux et autres méthodes similaires nécessitent de nombreux calculs relativement simples, plutôt qu'un seul calcul très complexe. Travailler en parallèle avec autant de petites puces est généralement préférable à utiliser des processeurs massifs et puissants.

C’est en grande partie la raison pour laquelle les GPU sont rapidement devenus plus populaires, car les cartes graphiques sont intrinsèquement conçues pour effectuer des milliers de petits calculs en parallèle.

La formation de l’IA d’aujourd’hui est largement basée sur les réseaux neuronaux, un concept qui a remporté le prix Nobel de physique en 2024, une récompense que nous avons couverte en détail dans un article dédié à l'époque.

Source: Prix Nobel

Une deuxième révolution dans l'IA est venue avec les « transformateurs ». Ils résolvent les problèmes des réseaux neuronaux traditionnels. incapacité à traiter efficacement de longues séquences de données, une caractéristique commune à tout langage naturel.

Introduit pour la première fois en 2017 par des chercheurs de Google, il est à l'origine de l'explosion actuelle des capacités de l'IA. Les transformateurs sont au cœur de produits d'IA tels que les LLM (Large Language Models), dont ChatGPT.

Exigences différentes

Une distinction importante dans les flux de travail de l’IA est la différence entre réglage fin et l'inférence, qui ont toutes deux des exigences matérielles distinctes.

- Réglage fin Il s'agit d'entraîner un modèle sur des données spécifiques à un domaine, ce qui nécessite une puissance de calcul et une mémoire importantes. Il s'agit d'une tâche très technique, souvent à la pointe de l'IA.

- Inférence se concentre sur l'utilisation d'un modèle déjà formé pour générer des sorties, exigeant moins de puissance de calcul mais mettant davantage l'accent sur la faible latence et la rentabilité.

- C’est ce que font plus couramment les experts en IA en déployant des modèles préexistants pour résoudre des problèmes réels.

Ainsi, bien que les coûts soient évidemment une préoccupation tant pour le réglage fin/la formation que pour l’inférence/l’utilisation de l’IA, la formation nécessitera souvent le meilleur matériel possible, tandis que les tâches d’utilisation se concentreront davantage sur le coût du matériel et la consommation d’énergie lors du choix de la meilleure option matérielle.

CPU vs GPU

Unités centrales de traitement (CPU) :

Les processeurs sont polyvalents et ne constituent pas spécifiquement du matériel d'IA. Ils restent néanmoins essentiels à l'exécution des instructions et aux calculs de base dans les systèmes d'IA.

La plupart des logiciels gérant l’interface avec les utilisateurs finaux d’un système d’IA seront également centrés sur le processeur, qu’il s’agisse d’ordinateurs individuels ou de logiciels basés sur le cloud.

Source: AnandTech

Les processeurs peuvent également être utilisés pour des IA très simples, où un matériel dédié n'est pas réellement requis. C'est particulièrement vrai lorsque le résultat n'est pas particulièrement urgent et que le traitement relativement plus lent des processeurs par l'IA ne pose pas de problème.

Ainsi, les petits modèles, avec de petits lots de données et de calculs, peuvent fonctionner correctement sur les processeurs. L'omniprésence des processeurs dans les ordinateurs classiques en fait également une bonne option pour l'utilisateur moyen qui ne souhaite pas investir dans du matériel spécifique à l'IA.

Les processeurs sont également très fiables et stables, ce qui en fait un bon choix pour les tâches critiques où l’absence d’erreur est un critère important.

Enfin, les processeurs sont utiles pour certaines tâches de formation de l’IA, généralement en collaboration avec d’autres types de matériel, comme le chargement, le formatage, le filtrage et la visualisation des données.

Unités de traitement graphique (GPU) :

Conçus à l'origine pour le rendu graphique, les GPU sont conçus pour le traitement parallèle, ce qui les rend idéaux pour l'entraînement de modèles d'IA nécessitant la gestion de grands ensembles de données. Le passage des CPU aux GPU a permis de réduire les temps d'entraînement de plusieurs semaines à quelques heures.

En raison de leur large disponibilité et de l’expérience des spécialistes informatiques qui travaillent avec eux, les GPU ont été le premier type de matériel informatique à être installé en série pour faire évoluer la recherche en IA.

Source: Aorus

Le développement de CUDA par Nvidia, une interface de programmation polyvalente pour les GPU NVIDIA, a également joué un rôle déterminant dans le succès des GPU, ouvrant la voie à d'autres usages que le jeu. Ce développement s'explique par le fait que certains chercheurs utilisaient déjà des GPU pour effectuer des calculs plutôt que les supercalculateurs habituels.

« Les chercheurs ont réalisé qu’en achetant cette carte de jeu appelée GeForce, vous l’ajoutez à votre ordinateur, vous avez essentiellement un superordinateur personnel.

Dynamique moléculaire, traitement sismique, reconstruction CT, traitement d'images : tout un tas de choses différentes.

Aujourd’hui, les GPU font toujours partie des types de matériel d’IA les plus recherchés, Nvidia parvenant à peine à produire suffisamment pour satisfaire la demande des géants de la technologie qui construisent des centres de données d’IA à l’échelle du gigawatt.

C'est aussi le début de « l'ère des super GPU », avec la sortie récente par Nvidia de le GB200 NVL72.

Ce matériel est conçu pour fonctionner comme un seul GPU massif dès sa sortie d'usine, évitant ainsi la mise en réseau de plusieurs petits GPU. Il est ainsi bien plus puissant que le modèle H100, qui battait auparavant des records.

Source: Nvidia

Cela devrait également être beaucoup plus économe en énergie, un point crucial car l'industrie de l'IA pourrait manquer d'énergie avant de manquer de puces, compte tenu de la vitesse à laquelle les centres de données d'IA se construisent. De plus, une meilleure efficacité de calcul et d'énergie signifie moins de chaleur résiduelle, ce qui résout également temporairement le problème de surchauffe.

| Type de matériel | Meilleur cas d'utilisation | Rapidité | L'efficacité énergétique | Souplesse |

|---|---|---|---|---|

| Processeur | Tâches à usage général | Faible | Élevée | Très élevé |

| GPU | Formation IA et tâches parallèles | Élevée | Moyenne | Moyenne |

| TPU | Opérations tensorielles et transformateurs | Très élevé | Élevée | Faible |

| ASIC | Accélération d'une tâche unique | Très élevé | Très élevé | Très Bas |

| FPGA | Charges de travail d'IA reconfigurables | Moyenne | Moyenne | Élevée |

L'essor des ASIC et du matériel d'IA

Les circuits intégrés spécifiques à une application (ASIC) sont du matériel informatique conçu spécifiquement pour une tâche informatique donnée, ce qui les rend encore plus spécialisés que les GPU encore relativement généralistes.

Ils sont donc moins flexibles et programmables que le matériel à usage général.

En règle générale, ils sont plus complexes et généralement plus coûteux, en raison du manque d'économies d'échelle pour leur production et du coût des conceptions sur mesure.

Ils sont cependant beaucoup plus efficaces dans la tâche qui leur est confiée, produisent généralement un résultat plus rapidement avec beaucoup moins de puissance de calcul et d'énergie gaspillées.

Les ASIC et autres matériels spécifiques à l'IA sont de plus en plus utilisés, car le secteur remarque progressivement que certains calculs ne sont pas idéalement effectués sur des GPU mais nécessitent des équipements plus spécialisés.

Unités de traitement tensorielles (TPU)

Les TPU ont été développés par Google (GOOGL -1.5%) Spécifiquement conçus pour effectuer des calculs tensoriels (liés au calcul basé sur les transformateurs). Ils sont optimisés pour une arithmétique à haut débit et à faible précision.

Source: C#Corner

Cela confère aux TPU des performances, une efficacité et une évolutivité élevées pour la formation de grands réseaux neuronaux.

Les TPU possèdent des fonctionnalités spécialisées, telles que l'unité de multiplication matricielle (MXU) et la topologie d'interconnexion propriétaire, qui les rendent idéales pour accélérer la formation et l'inférence de l'IA.

Les TPU alimentent Gemini et toutes les applications basées sur l'IA de Google, telles que la recherche, les photos et les cartes, au service de plus d'un milliard d'utilisateurs.

Ce type de matériel peut accélérer considérablement le développement et le fonctionnement des réseaux neuronaux, où l’erreur occasionnelle est moins importante, car ces modèles dépendent fortement des statistiques et d’un grand nombre de calculs pour commencer.

Parmi les tâches des utilisateurs finaux les plus adaptées aux TPU figurent l’apprentissage en profondeur, la reconnaissance vocale et la classification d’images.

Processeurs de réseaux neuronaux (NNP) :

Également apparentées aux unités de traitement neuronal (NPU) et appelées puces neuromorphiques, les NPP sont spécialisées dans le calcul des réseaux neuronaux, conçues pour imiter les connexions neuronales du cerveau humain. On les appelle aussi parfois « accélérateurs d'IA », bien que ce terme soit moins précis.

Une NPU intégrera également le stockage et le calcul grâce à des pondérations synaptiques. Elle pourra ainsi s'adapter ou « apprendre » au fil du temps, améliorant ainsi son efficacité opérationnelle.

Une NPU comprend des modules spécifiques pour la multiplication et l'addition, les fonctions d'activation, les opérations de données 2D et la décompression.

Le module spécialisé de multiplication et d'addition est utilisé pour effectuer des opérations pertinentes pour le traitement des applications de réseaux neuronaux, telles que le calcul de la multiplication et de l'addition de matrices, la convolution, le produit scalaire et d'autres fonctions.

La spécialisation peut aider une NPU à réaliser une opération en un seul calcul, au lieu de plusieurs milliers avec un matériel généraliste. Par exemple : IBM affirme que le NPU peut améliorer radicalement l'efficacité du calcul de l'IA par rapport aux GPU.

« Les tests ont montré que les performances de certains NPU étaient plus de 100 fois supérieures à celles d'un GPU comparable, avec la même consommation d'énergie. »

En raison de cette efficacité énergétique, les NPU sont populaires auprès des fabricants pour être installés dans les appareils des utilisateurs, où ils peuvent aider à effectuer des tâches locales pour les applications d'IA génératives, un exemple de « edge computing ». (voir ci-dessous pour plus d'informations sur ce sujet).

De nombreuses méthodes sont actuellement explorées pour créer des puces neuromorphiques :

- Exploiter la ferroélectricité naissante, un phénomène encore mal compris.

- Substrat actif utilisant du vanadium ou du titane.

- Utilisation de memristors, un nouveau type de composant électronique, qui peut effectuer des tâches d'IA à 1/800thde la consommation électrique normale.

Auxiliaire Ptraitement Ulente (XPU)

XPU fusionne le CPU (processeur), le GPU (carte graphique / processeurs parallèles) et la mémoire dans le même appareil électronique.

Source: Broadcom

XPU est un terme large, englobant de nombreuses variantes de ce concept consistant à regrouper tout le matériel dans des unités autonomes, y compris Unités de traitement de données (DPU), Unités de traitement d'infrastructure (IPU), et Cartes d'accélération de fonctions (FAC).

Les XPU sont considérés comme une solution à un problème croissant des centres de données IA, à savoir le besoin croissant de connectivité entre les sous-unités, au point où le décalage des données devient un facteur important de ralentissement du calcul, plus que la puissance de calcul disponible.

Essentiellement, les puces (GPU, TPU, NPP, etc.) attendent les données autant qu’elles fonctionnent réellement.

Broadcom est un leader de cette technologie (AVGO -0.66%), Qui nous en avons discuté en détail dans un rapport d'investissement dédié.

Réseaux de portes programmables par l'utilisateur (FPGA) :

Les FPGA sont des processeurs programmables, ce qui les rend nettement plus flexibles et reconfigurables que les ASIC, plus rigides. Ils peuvent être personnalisés pour des algorithmes d'IA spécifiques, offrant ainsi potentiellement des performances et une efficacité énergétique supérieures.

Source: Laboratoires de microcontrôleurs

Cette flexibilité a un prix : les FPGA sont généralement plus complexes, plus chers et consomment davantage d'électricité. Ils peuvent néanmoins s'avérer plus efficaces que le matériel généraliste.

Cela en fait un produit de niche, où leur flexibilité compense les inconvénients. Par exemple, l'apprentissage automatique, la vision par ordinateur et le traitement du langage naturel peuvent bénéficier de la polyvalence des FPGA.

Mémoire à large bande passante (HBM) :

Les développements les plus importants en matière de matériel personnalisé centré sur l’IA ont eu lieu dans le domaine de la puissance de calcul, qui a longtemps été le point d’étranglement dans la construction de davantage de capacités de calcul pour former de nouvelles IA.

Cependant, ces systèmes nécessitent également des systèmes de support à haute efficacité, dont la mémoire est un élément important. La mémoire HBM offre, comme son nom l'indique, une bande passante supérieure à celle de la DRAM traditionnelle.

Ce procédé est obtenu en empilant verticalement plusieurs matrices DRAM et en les connectant par des vias traversants en silicium (TSV). La première génération de HBM a été développée en 2013.

L'empilement vertical permet d'économiser de l'espace et de réduire la distance physique que les données doivent parcourir, accélérant ainsi le transfert de données, un incontournable dans le calcul de l'IA.

Les HBM sont plus complexes à fabriquer et plus chers que les DRAM, mais les avantages en termes de performances et d'efficacité énergétique justifient souvent le coût plus élevé des applications d'IA.

Infrastructure de centre de données IA : alimentation, refroidissement et connectivité

Outre la mémoire et la puissance de calcul, les systèmes auxiliaires des centres de données d'IA sont également importants. Sans eux, les données ne peuvent pas circuler suffisamment vite, les puces surchaufferaient ou la puissance disponible serait insuffisante.

Cela signifie que, par exemple, le matériel de connectivité Broadcom bénéficie également grandement de l'accumulation de centres de données IA, tout comme les solutions spécialisées telles que les fournisseurs d'équipements de refroidissement, par exemple Vertiv. (VRT -1.52%) ou Schneider Electric (SU.PA).

L’approvisionnement en électricité pourrait également devenir un problème, et plusieurs géants de la technologie tentent de s’attaquer au problème en misant sur l’énergie nucléaire. avec la première action de Microsoft en 2024, suivi par beaucoup d'autres depuis.

Associé à un engagement des entreprises technologiques à réduire l'empreinte carbone de l'IA, cela devrait grandement profiter aux entreprises du secteur de l'énergie nucléaire ou renouvelable, comme Cameco (CCJ -1.47%), GE Vernova (GEV -1.04%), First Solar (FSLR + 2.14%), NextEra (NEE + 2.75%), ou Partenaires énergétiques Brookfield (BEP -0.55%) (suivez les liens pour un rapport sur chaque entreprise).

Technologies informatiques émergentes en matière d'IA

Informatique quantique

Étant donné que l’IA est si gourmande en puissance de calcul, il est possible que l’avenir du matériel du domaine ne soit même pas à la hauteur des solutions silicium actuellement disponibles.

Une possibilité est que l’informatique quantique puisse être utilisée pour détecter des modèles beaucoup plus efficacement que l’informatique classique ne le pourrait jamais, quelque chose déjà exploré par les chercheurs.

L'informatique quantique dans son ensemble pourrait être utilisée pour résoudre certains calculs spécifiques, quasiment impossibles à réaliser avec l'informatique binaire. Cette approche sera probablement appliquée à l'IA, mais les premiers ordinateurs quantiques commerciaux ne verront le jour que dans quelques années, et un grand réseau quantique encore plus tard.

Photonics

En utilisant la lumière au lieu des électrons pour transporter des données, la photonique pourrait être beaucoup plus rapide que les appareils électroniques.

Étant donné que les ordinateurs quantiques transportent généralement des données quantiques avec des photons intriqués, il existe également de nombreux chevauchements entre l'informatique quantique et la photonique, et la première puce photonique quantique double a déjà été annoncée.

Organoïdes

Alors que la plupart des IA reproduisent dans les ordinateurs le fonctionnement des réseaux neuronaux du cerveau, certains chercheurs se demandent si nous ne pourrions pas plutôt utiliser… de véritables cellules cérébrales.

C'est une idée intrigante, surtout que certaines recherches pourraient indiquer que le cerveau est en fait un ordinateur quantique organique.

Ce type d'« ordinateur » est appelé organoïde et se compose essentiellement de neurones cultivés en laboratoire sur une puce informatique. Les neurones auto-organisent ensuite leurs dendrites et leurs connexions en réponse au stimulus de la puce.

Cette technologie est encore nouvelle et repose sur impression bio-3D.

Autres

Nous avons exploré d’autres alternatives à l’informatique sur silicium dans «Top 10 des sociétés informatiques sans silicium», tels que le dioxyde de vanadium, le graphène, la grille redox ou les matériaux organiques.

Chacune promet d'être beaucoup plus rapide ou beaucoup moins énergivore que l'informatique classique sur silicium. Cependant, elles sont encore relativement nouvelles et peu susceptibles de révolutionner le domaine de l'IA à l'échelle commerciale, du moins dans les 5 à 10 prochaines années.

IA Cloud et IA Edge : tendances en matière d'accessibilité

IA cloud

Les systèmes d'IA les plus puissants étant conçus par de grandes entreprises technologiques, ils sont généralement accessibles via le cloud. Il en va de même pour l'accès au matériel spécialisé en IA.

Le leader de cette tendance est Tissage de base (CRCW -3.13%), une entreprise qui est passée du statut de fournisseur de cloud à celui de fournisseur de crypto-monnaie à l'aide de GPU, pour aujourd'hui fournir du calcul d'IA à la demande.

Cela a fait de CoreWeave un partenaire clé des startups d'IA à venir qui tentent de concurrencer les géants de la technologie, comme IA d'inflexion : besoins particuliers, topographie du site et intégration paysagère. Cluster GPU de 1.3 milliard de dollars, financé par un nouveau tour de table.

« Il y a deux mois, une entreprise n’existait peut-être pas et aujourd’hui, elle peut disposer de 500 millions de dollars de financement en capital-risque.

Et la chose la plus importante pour eux est de sécuriser l'accès au calcul ; ils ne peuvent pas lancer leur produit ou leur entreprise tant qu'ils ne l'ont pas.

Alors que les acteurs du matériel d'IA se méfient des grandes technologies qui produisent leurs propres GPU, TPU, XPU, etc. et évoluent du statut de clients à celui de concurrents, il est probable que des entreprises comme CoreWeave auront un accès prioritaire à la dernière version matérielle de Nvidia et d'autres.

Ce modèle économique sera probablement particulièrement important pour la formation de l’IA, qui est beaucoup plus exigeante en termes de capacité de calcul que la simple utilisation des IA déjà formées.

Edge Computing et PC IA

Un autre cas d’informatique IA qui évolue rapidement est la nécessité de réaliser le calcul des systèmes d’IA sur site, aussi près que possible des situations réelles.

C'est indispensable pour les systèmes qui pourraient ne pas tolérer d'être déconnectés de l'IA si la connexion échoue ou lorsque la latence des allers-retours avec le cloud est trop lente.

Un bon exemple est celui des voitures autonomes, qui sont censées comprendre leur environnement hors ligne.

Ce type de calcul est appelé edge computing et bénéficie grandement d'un matériel plus efficace et moins gourmand en énergie.

Cela peut augmenter la fiabilité de l’IA et, à mesure que les modèles deviennent plus efficaces, comme l’illustre le bond en avant de DeepSeek, cela pourrait devenir un modèle de déploiement de l’IA plus répandu à l’avenir.

Pour la même raison, les PC IA comme celui récemment lancé par Nvidia, pourrait à long terme suffire à exécuter de nombreuses applications d'IA localement, augmentant ainsi la confidentialité et la sécurité par rapport aux IA toujours connectées au cloud.

Conclusion

Le matériel d'IA a longtemps été synonyme de GPU, car les cartes graphiques étaient bien plus efficaces pour entraîner l'IA que d'autres types de matériel comme les CPU. C'est ce qui a fait la fortune de Nvidia et de nombre de ses premiers actionnaires.

Les GPU, en particulier les « super GPU » axés sur l'IA, resteront probablement importants dans la construction de centres de données IA. Mais ils deviendront un simple composant parmi d'autres de systèmes de plus en plus complexes et spécialisés.

Les opérations de transformation seront envoyées aux TPU, les réseaux neuronaux seront chargés aux NPP, les tâches répétitives seront envoyées aux ASIC dédiés ou aux FPGA reconfigurés.

Pendant ce temps, une mémoire à large bande passante, des connecteurs de télécommunication avancés et un refroidissement ultra-efficace permettront de maintenir en fonctionnement toutes les fonctions auxiliaires autour du cœur de calcul.

Pour l'informatique de pointe et les IA plus petites que les LLM massifs, l'informatique locale, peut-être alimentée par des XPU tout-en-un, sera probablement utilisée par les scientifiques, les voitures autonomes et les utilisateurs préoccupés par la confidentialité ou la censure, potentiellement avec des modèles d'IA open source.

Ce qui est sûr, c’est que les profits tirés de la vente des « pioches et pelles » de matériel d’IA dans la ruée vers l’or de l’IA sont loin d’être terminés.

Après une période de domination de Nvidia, les investisseurs pourraient vouloir diversifier les risques en étendant leur portefeuille de matériel IA à d'autres conceptions, et peut-être même aux sociétés de services publics d'électricité qui fourniront les précieux gigawatts nécessaires au fonctionnement des centres de données IA de plus en plus grands et nombreux dans le monde.