Intelligence Artificielle

Intelligence Artificielle en Bordure : Pourquoi AMD représente le meilleur investissement en 2026

L'intelligence artificielle (IA) est l'une des principales innovations technologiques de cette décennie. provoquer des changements fondamentaux dans tous les secteurs d'activité et dans la société en général.

Les données montrent qu'environ une personne sur six Partout dans le monde, les outils d'IA générative sont désormais utilisés. De plus, 90 % des professionnels du secteur technologique utilisent déjà l'IA dans leur travail. Malgré cette adoption, le marché de l'IA devrait encore croître d'environ neuf fois d'ici 2033.

Cette adoption massive s'accompagne d'une flambée des coûts de calcul, de problèmes de latence croissants et de préoccupations grandissantes concernant la sécurité, la consommation d'énergie et l'évolutivité. Les entreprises prennent désormais conscience que l'envoi constant de données à des serveurs distants pour l'inférence par l'IA (cloud computing ou IA dans le cloud) est coûteux, lent et comporte des risques pour la confidentialité.

Dans le domaine de l'IA dans le cloud, les entreprises exploitent les vastes ressources de plateformes telles qu'AWS, Azure et Google Cloud pour fournir des services d'IA. Cela permet aux utilisateurs d'accéder à des modèles d'IA à la demande via Internet, sans avoir à construire leur propre infrastructure.

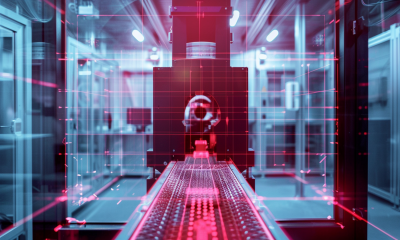

L'intelligence artificielle dans le cloud repose sur les hyperscalers, d'immenses centres de données dédiés à l'IA qui offrent une évolutivité extrême pour gérer des charges de travail bien supérieures aux capacités des infrastructures sur site traditionnelles. Grâce à leurs vastes baies de serveurs horizontales, ils fournissent aux entreprises les ressources nécessaires pour accéder, créer, entraîner, déployer et maintenir efficacement des applications d'IA.

L'association du cloud computing et de l'IA offre des avantages en termes de rentabilité, d'évolutivité et de possibilité d'exploiter des modèles partagés. Cependant, elle présente également des inconvénients majeurs, notamment des coûts récurrents élevés liés aux ressources de calcul, au stockage, au transfert de données et à l'expertise spécialisée requise pour une utilisation continue.

Parmi les autres problèmes rencontrés par l'IA dans le cloud, on peut citer la latence, les risques de sécurité, la confidentialité des données, la dépendance à Internet, le contrôle limité et la dépendance vis-à-vis du fournisseur.

Face au coût élevé et aux difficultés rencontrées par le cloud pour les applications grand public, les ordinateurs portables, les systèmes industriels et les cas d'utilisation en temps réel, les entreprises se tournent vers l'« IA en périphérie ». L'exécution d'inférences locales sur l'appareil, plutôt que de s'appuyer sur des GPU cloud onéreux, redéfinit désormais la manière dont l'IA est déployée au-delà des centres de données.

Glissez pour faire défiler →

| Dimension | IA dans le cloud (inférence centralisée) | IA en périphérie (inférence locale/sur l'appareil) |

|---|---|---|

| Latence | Les allers-retours sur le réseau ajoutent du délai ; ce délai est variable en fonction de la charge. | Temps de réponse de l'ordre de la milliseconde ; performances stables |

| Unité d'économie | Factures récurrentes pour GPU + bande passante + stockage | Coût initial du silicium ; amorti sur la durée de vie de l'appareil |

| Confidentialité et conformité | Les données quittent l'appareil ; exposition accrue et frais de gouvernance supplémentaires | Les données sensibles peuvent rester localement ; surface d'exposition réduite |

| Fiabilité | Sous réserve de la disponibilité d'Internet et du service | Fonctionne hors ligne ou sur des réseaux dégradés |

| Évolutivité | Évolutivité via la capacité du centre de données et l'offre de GPU | Échelles en répartissant l'inférence sur les points d'extrémité |

| Meilleur ajustement | Formation, inférence par lots massifs, analyse centralisée | Applications en temps réel : PC, robotique, véhicules, caméras, industrie |

L'IA embarquée expliquée : pourquoi l'inférence se déplace sur l'appareil

L'industrie connaît actuellement une mutation stratégique et architecturale vers l'IA en périphérie, déplaçant l'IA des centres de données centralisés et énergivores vers du matériel d'inférence local.

L'intelligence artificielle en périphérie (Edge AI) combine l'intelligence artificielle et le calcul en périphérie pour s'affranchir du cloud en permettant aux appareils de traiter les données localement. Le terme « périphérie » désigne ici l'appareil utilisé (téléphone, voiture, appareil photo, télévision, capteur ou dispositif médical, par exemple). Le calcul en périphérie signifie donc que l'ordinateur conçu pour traiter les données est situé à proximité ou à l'intérieur de cet appareil.

Outre les dispositifs périphériques qui collectent et traitent les données, les autres composants clés comprennent des modèles d'IA entraînés dans le cloud et déployés en périphérie, ainsi que des puces matérielles spécialisées qui gèrent efficacement les tâches d'IA localement.

Avec ce virage vers des appareils à faible consommation d'énergie, l'objectif est de résoudre les problèmes critiques de latence et de confidentialité des données en permettant un traitement en temps réel sur les appareils des utilisateurs, là où les données sont réellement générées.

Cela signifie qu'au lieu d'envoyer les données à un centre de données externe, les calculs sont effectués au plus près de la source, permettant ainsi aux appareils de prendre des décisions en quelques millisecondes sans connexion Internet. Les données sont donc utilisées immédiatement après leur création par l'appareil.

Ce traitement en temps réel est crucial pour la robotique, les véhicules autonomes et les applications de surveillance qui nécessitent des temps de réponse rapides.

L'informatique de périphérie allège également la charge importante pesant sur les centres de données en éliminant les transferts de données incessants. Dans le cadre de l'IA de périphérie, seules les données pertinentes sont envoyées au cloud, ce qui réduit les besoins en bande passante et les coûts associés.

Outre la rentabilité, le passage des centres de données à l'échelle du gigawatt aux appareils présente l'avantage d'une meilleure efficacité énergétique, ces derniers pouvant exécuter l'IA avec une consommation minimale. En conservant les données sensibles localement, les entreprises renforcent la sécurité et se protègent contre les accès non autorisés et les violations de données.

Grâce à ses avantages en termes de rapidité, de coût, de confidentialité et d'efficacité énergétique, l'inférence IA est de plus en plus réalisée en périphérie du réseau.

En intelligence artificielle, l'inférence correspond au fonctionnement effectif du modèle : un processus qui débute après son entraînement et la fin de son apprentissage. L'inférence est le moment où le modèle se met à l'œuvre, tirant des conclusions des données et transformant ces connaissances en résultats concrets.

L'inférence locale fait référence à l'exécution de modèles d'IA directement sur la machine d'un utilisateur à l'aide de silicium spécialisé, tel que des NPU (unités de traitement neuronal) intégrées dans les CPU ou les systèmes sur puce (SoC), plutôt que de renvoyer chaque requête à un GPU cloud.

Les NPU sont des puces d'IA optimisées pour les calculs complexes dans les tâches d'apprentissage profond telles que le traitement du langage naturel, le traitement de la parole, la détection d'objets et la reconnaissance d'images. Ces puces d'accélération d'IA spécialisées permettent une inférence rapide sur l'appareil avec une consommation d'énergie minimale, rendant possible les applications en temps réel.

En pratique, l'inférence locale signifie que votre ordinateur portable, votre PC, votre système embarqué ou même votre smartphone peuvent exécuter de grands modèles de langage (requêtes LLM), des modèles de vision ou des charges de travail d'assistance sans solliciter de serveurs volumineux, coûteux et puissants.

Cela réduit la latence, diminue les coûts de bande passante, améliore la confidentialité et diminue les factures de serveur. Les systèmes d'IA en périphérie, capables de fonctionner sans connexion Internet permanente, offrent une fiabilité accrue et sont donc parfaitement adaptés aux zones reculées.

À mesure que les charges de travail de l'IA passent de l'expérimentation à l'utilisation quotidienne, ce passage à l'inférence locale n'est plus théorique mais une nécessité, car des milliards d'appareils acquièrent des capacités d'IA et l'inférence basée sur le cloud devient insoutenable à grande échelle.

IA de pointe estimations d'études de marché Les processeurs d'IA en périphérie pourraient valoir près de 60 milliards de dollars d'ici la fin de cette décennie, contre 9 milliards en 2020, une croissance largement due à la puissance de calcul locale des PC et des appareils.

Déjà cette année, la tendance de l'inférence locale est passée des démonstrations de recherche aux produits réels, comme l'a montré le CES 2026, où des dizaines de PC IA et de formats périphériques ont été présentés avec des capacités d'inférence embarquées.

Par exemple, Ambarella a lancé son SoC CV7 Vision Qualcomm a renforcé son intégration verticale pour une « informatique intelligente partout » grâce à un traitement IA embarqué avancé, permettant de répondre aux besoins de diverses applications de perception en temps réel. PC Snapdragon X Elite Gen 2Broadcom l'est également mettant l'accent sur l'intégration de « moteurs neuronaux » dans les processeurs pour permettre une IA locale, ciblant spécifiquement les applications de maison intelligente.

Quand il s'agit de géants comme Apple (AAPL -0.26%) et NVIDIA (NVDA -0.71%), le premier utilise un modèle hybride de AI sur l'appareil et "Calcul en cloud privé, tandis que ce dernier évolue vers «IA physique« et le traitement embarqué. »

L'IA physique, qui étend l'IA au-delà du monde numérique pour inclure la robotique, les drones et les machines industrielles, est l'une des tendances émergentes du secteur de l'IA en périphérie et devrait constituer un moteur de croissance majeur.

Pourquoi AMD est bien positionné pour remporter le cycle de vie du matériel d'IA en périphérie

Dans le monde des actions liées à l'IA de périphérie, l'un des noms les plus importants à suivre est Advanced Micro Devices (AMD -0.61%), qui développe des semi-conducteurs, des processeurs et des GPU pour les centres de données, l'IA, les jeux et les applications embarquées.

Plus tôt ce mois-ci, à CES 2026La présidente-directrice générale d'AMD, Lisa Su, a partagé l'objectif de l'entreprise : fournir L'IA pour tous alors qu'elle mettait en évidence un stratégie d'IA axée sur la périphérie sur les PC, les appareils embarqués et les développeurs, renforçant ainsi l'intérêt de l'entreprise pour le matériel d'inférence local au-delà des environnements cloud hyperscale.

Dans le cadre de cette stratégie, l'entreprise a lancé une nouvelle gamme de processeurs IA. Celle-ci comprend le processeur Ryzen AI série 400 pour PC dédiés à l'IA, doté d'unités de traitement réseau (NPU) intégrées offrant une puissance de calcul d'environ 60 TOPS pour l'inférence locale. Cette dernière version des puces AMD pour PC, optimisées par l'IA, dispose de 12 cœurs et 24 threads, permettant un multitâche 1.3 fois plus rapide que ses concurrents. Elle est également 1.7 fois plus performante pour la création de contenu.

Les PC, notamment ceux équipés du processeur Ryzen AI série 400, seront disponibles au cours de ce trimestre.

Lors d'une conférence de presse, Rahul Tikoo, vice-président senior et directeur général de la division clients d'AMD, a indiqué que l'entreprise avait déjà étendu son offre à plus de 250 plateformes PC IA, soit une croissance de 2 % par rapport à l'année précédente. Il a déclaré :

« Dans les années à venir, l’IA va se transformer en une structure multicouche qui s’intégrera à tous les niveaux de l’informatique personnelle. Nos ordinateurs et appareils dotés d’IA révolutionneront notre façon de travailler, de nous divertir, de créer et de communiquer. »

AMD a également présenté les puces Ryzen AI Max+ lors du plus grand salon mondial de l'électronique grand public. Elles sont destinées aux ordinateurs portables et mini-PC haut de gamme et offrent des performances avancées en matière d'inférence locale, de création de contenu et de jeux.

Pour les développeurs, AMD a annoncé la plateforme Ryzen AI Halo pour le développement de modèles embarqués, qui devrait apporter de puissantes capacités de développement d'IA à un PC de bureau compact au cours du prochain trimestre.

Sa nouvelle gamme de processeurs x86 embarqués est conçue pour alimenter les applications d'IA en périphérie de réseau. Les nouveaux processeurs des séries P100 et X100 offrent une puissance de calcul IA élevée pour la santé connectée, les cockpits numériques automobiles et la robotique humanoïde.

« Peu importe qui vous êtes et votre utilisation quotidienne de la technologie, l'IA redéfinit l'informatique de tous les jours. Vous interagissez des milliers de fois par jour avec votre ordinateur. L'IA est capable de comprendre, d'apprendre le contexte, d'automatiser les tâches, de fournir un raisonnement approfondi et une personnalisation pour chaque utilisateur. »

– Rahul Tikoo, vice-président principal et directeur général des activités clients

Grâce à ces initiatives, le fabricant américain de puces cible les charges de travail d'IA embarquées et contribue à l'essor de l'industrie. orienter vers l'inférence locale et intelligence distribuée sur des milliards de points de terminaison.

Outre sa capacité à permettre le calcul d'IA en périphérie de réseau, l'entreprise a présenté ses processeurs d'IA avancés, utilisés dans les baies de serveurs des centres de données. Une version entreprise de la puce de la série MI400 (la MI440X) a été conçue pour une utilisation sur site, mais n'est pas spécifiquement destinée aux clusters d'IA.

Pour répondre aux futurs besoins informatiques d'entreprises comme OpenAI, AMD a également présenté en avant-première la plateforme MI500. Selon la société, cette plateforme est conçue pour offrir des gains de performance considérables au niveau du système et du rack par rapport aux générations précédentes, et non pas une simple mise à niveau puce par puce. Ces puces seront commercialisées l'année prochaine.

Outre un portefeuille de produits impressionnant, AMD peut se targuer d'une excellente liste de clients, parmi lesquels OpenAI, Blue Origin, Liquid AI, Luma AI, World Labs, Illumina, Absci, AstraZeneca et Generative Bionics, qui ont tiré parti de la technologie de l'entreprise pour transformer la promesse de l'IA en un impact concret dans le monde réel. Selon Su:

« Avec l’accélération de l’adoption de l’IA, nous entrons dans l’ère du calcul à l’échelle du yotta, portée par une croissance sans précédent des capacités d’entraînement et d’inférence. AMD construit l’infrastructure informatique nécessaire à cette nouvelle phase de l’IA grâce à un leadership technologique global, des plateformes ouvertes et une co-innovation étroite avec ses partenaires de l’écosystème. »

Dans une interview, elle a souligné que, compte tenu de la demande « incroyable » en matière d'IA, qui « explose », il faudra des investissements massifs et inévitables dans la puissance de calcul et le matériel de pointe pour rester compétitif sur le marché de l'IA.

D'après elle, le monde aurait besoin de plus de 10 yottaflops de puissance de calcul, soit 10 000 fois plus qu'en 2022, pour suivre le rythme de la croissance de l'IA. Dans cette optique, elle a présenté le plan de l'entreprise pour une infrastructure à l'échelle du yottaflop, dévoilant la plateforme AMD « Helios » au format rack, qui offrira jusqu'à 3 exaflops de performance pour l'IA dans un seul rack.

Lors de ce même événement, le principal concurrent d'AMD, Nvidia, a lancé son plateforme Vera Rubin de nouvelle génération, comprenant six puces et dont le lancement est prévu plus tard cette année.

Tandis que Nvidia continue de miser sur l'hyperscale avec des GPU haut de gamme et des solutions d'entreprise, AMD adopte une approche diversifiée pour ses produits, permettant des fonctionnalités d'IA à moindre coût. Ce contraste alimente de plus en plus le débat entre AMD et NVIDIA à l'horizon 2026.

AMD pratique des prix inférieurs à ceux de NVIDIA pour ses puces destinées aux PC IA, afin de conquérir une part plus importante du marché émergent des PC IA en rendant les processeurs hautes performances compatibles IA plus abordables pour les constructeurs et les consommateurs. De ce fait, AMD est considérée comme l'une des valeurs IA les plus sous-évaluées du marché.

À partir de janvier 20, 2026AMD, dont la capitalisation boursière s'élève à 377.4 milliards de dollars, se négocie à 231.87 dollars, en hausse de 8.25 % depuis le début de l'année et de 90.87 % sur les douze derniers mois. Son BPA (sur douze mois glissants) est de 1.92 et son PER (sur douze mois glissants) de 120.97.

Advanced Micro Devices, Inc. (AMD -0.61%)

La situation financière d'AMD est également solide, comme le souligne Jean Hu, vice-président exécutif, directeur financier et trésorier d'AMD : « Nos investissements continus dans l'IA et le calcul haute performance génèrent une croissance significative et positionnent AMD pour créer de la valeur à long terme. »

Cela se manifeste clairement dans le chiffre d'affaires record de 9.2 milliards de dollars enregistré par cette entreprise mondiale de semi-conducteurs au troisième trimestre 2025. Ce montant comprend 4.3 milliards de dollars provenant du segment des centres de données, en hausse de 22 % sur un an, 4 milliards de dollars provenant des revenus combinés des clients et des jeux, en hausse de 73 % sur un an, et 857 millions de dollars provenant du segment embarqué, en baisse de 8 % sur un an.

Le chiffre d'affaires d'AMD n'inclut toujours pas les livraisons de ses puces Instinct MI308 à la Chine, contrairement au trimestre précédent, même si l'entreprise prévoit des revenus prochainement. « Nous avons obtenu des licences pour la MI308 », avait alors indiqué Su. « Nous continuons de travailler avec nos clients sur la demande et les opportunités globales. »

Son résultat d'exploitation pour la période s'est élevé à 1.3 milliard de dollars, et son résultat net à 1.2 milliard de dollars, tandis que sa marge brute a atteint 52 %. Son bénéfice par action dilué était de 0.75 dollar.

« Nous avons réalisé un trimestre exceptionnel, avec un chiffre d'affaires et une rentabilité records, témoignant d'une forte demande pour nos processeurs hautes performances EPYC et Ryzen ainsi que pour nos accélérateurs d'IA Instinct », a déclaré Mme Su. « Cela marque une nette accélération dans notre trajectoire de croissance, notre activité de calcul en expansion et notre activité d'IA pour centres de données, en pleine croissance, générant une augmentation significative du chiffre d'affaires et des bénéfices », a-t-elle ajouté.

À l'époque, le géant des semi-conducteurs avait noté que la dynamique des clients pour ses plateformes d'IA s'accélérait, comme en témoignait le renforcement de ses partenariats avec OpenAI, Oracle (ORCL + 2.97%), Cisco (CSCO + 0.34%), IBM (IBM -1.32%)et Cohérent.

Le département américain de l'Énergie a également conclu un partenariat d'un milliard de dollars avec AMD pour construire deux supercalculateurs de nouvelle génération qui accéléreront considérablement les progrès dans le développement de médicaments, l'énergie nucléaire et les technologies de sécurité nationale. Le premier, baptisé Lux, sera équipé de puces d'intelligence artificielle et de puces réseau MI355X, ce qui en fera le premier supercalculateur américain dédié à l'IA. Le supercalculateur Discovery, plus avancé, sera basé sur la série de puces d'IA MI430.

Pour le dernier trimestre, AMD prévoit un chiffre d'affaires d'environ 9.6 milliards de dollars et une marge brute non GAAP de 54.5 %.

La semaine dernière, TSMC, partenaire de fabrication d'AMD et principal sous-traitant de semi-conducteurs, a également dépassé les prévisions de chiffre d'affaires en annonçant une hausse de 35 % de son bénéfice au quatrième trimestre. L'entreprise prévoit d'accroître ses investissements cette année, signe de sa confiance dans le développement de l'intelligence artificielle.

« Nous prévoyons que notre activité sera soutenue par une forte demande continue pour nos technologies de pointe en matière de procédés. »

– Wendell Huang, directeur financier de TSMC

Ainsi, tout en s'efforçant de suivre le rythme de Nvidia, AMD investit davantage dans les accélérateurs d'IA, l'informatique de périphérie et les plateformes économiques, se positionnant comme une alternative intéressante et axée sur la valeur dans le paysage en constante évolution de l'IA.

L'IA en périphérie est le prochain grand cycle matériel

Le paysage de l'IA évolue à un rythme effréné, s'intégrant à tous les appareils, des smartphones aux objets connectés, en passant par les écrans, les drones, les robots et les véhicules autonomes. À mesure que les modèles d'IA gagnent en efficacité et que cette technologie passe de l'expérimentation au déploiement et à la mise à l'échelle, l'industrie délaisse le cloud au profit de la périphérie du réseau pour accompagner l'essor de l'IA.

Alors que Nvidia continue de dominer l'entraînement des données dans les centres de données et l'inférence à très grande échelle grâce à ses GPU haut de gamme et à son écosystème fermé, le cycle de vie du matériel informatique se déplace désormais des centres de données centralisés vers les appareils du quotidien, où la valeur, l'efficacité et le prix sont primordiaux. Dans cette nouvelle ère de l'IA embarquée, AMD se distingue par son orientation stratégique axée sur l'inférence locale, les NPU intégrés et les processeurs pour PC dédiés à l'IA, ce qui en fait un investissement particulièrement attractif en 2026.

L'IA en périphérie (Edge AI) n'en est qu'à ses débuts, mais son potentiel est immense. En intégrant l'intelligence à chaque appareil, elle permet à l'IA de fonctionner partout, indépendamment de toute connexion internet. À mesure que tout devient un ordinateur, les opportunités offertes par l'IA en périphérie pourraient s'avérer colossales, surpassant même celles du cloud. Cependant, plutôt que de le remplacer, l'avenir de l'IA sera probablement hybride : les plateformes cloud se chargeront de l'entraînement tandis que les dispositifs en périphérie assureront l'inférence en temps réel, marquant ainsi le prochain grand paradigme informatique.