Intelligence artificielle

Les technologies émergentes qui façonnent l'avenir du matériel d'IA

Securities.io maintient des normes éditoriales rigoureuses et peut recevoir une compensation pour les liens passés en revue. Nous ne sommes pas un conseiller en investissement enregistré et ceci n'est pas un conseil en investissement. Veuillez consulter notre divulgation de l'affiliation.

Un nouveau type d'informatique

Ces dernières années, les progrès exponentiels de la technologie de l'IA ont fait de grands gagnants parmi les constructeurs de matériel d'IA. En effet, l'IA moderne, qui utilise principalement la technologie des réseaux neuronaux, utilise la puissance de calcul d'une manière très différente des ordinateurs classiques.

Au lieu d'effectuer des calculs complexes à l'aide d'un puissant processeur, ils effectuent des milliers ou des millions de calculs plus simples en parallèle.

(Pour en savoir plus sur l'invention et le fonctionnement des réseaux neuronaux, voir "Investing in Nobel Prize Achievements - Les réseaux neuronaux artificiels, base de l'IA")

Jusqu'à présent, les cartes graphiques, ou GPU (Graphics processing units), ont été l'outil privilégié pour développer l'IA, ce qui a considérablement augmenté les revenus et les bénéfices des leaders du secteur tels que Nvidia (NVDA -3.65%).

Le marché du matériel d'IA devrait continuer à croître exceptionnellement vite, avec un TCAC de 31,2% entre 2025 et 2035.

Source : Analyse des racines

Cette période devrait également voir l'émergence de nombreux nouveaux types de matériel d'IA, les GPU réaffectés au calcul de l'IA étant progressivement remplacés par des puces conçues spécifiquement pour cette application.

À long terme, des formes de calcul plus exotiques feront probablement leur apparition sur le marché du matériel d'IA, qu'il s'agisse de conceptions spécifiques à des applications, de puces sans silicium ou même de l'utilisation de véritables neurones biologiques.

Comment fonctionne la pensée IA

La différence fondamentale entre les superordinateurs classiques et les IA réside dans la manière dont les données sont traitées. Au lieu de résoudre des calculs complexes, les réseaux neuronaux créent des nœuds virtuels connectés en réseau. Alors que le réseau neuronal initial contenait à peine quelques dizaines de nœuds, établissant quelques centaines de connexions, les réseaux neuronaux modernes, comme ceux utilisés par ChatGPT, utilisent des trillions de connexions possibles, atteignant des niveaux de complexité proches de ceux du cerveau humain.

Source : Prix Nobel

Cette méthode de calcul différente nécessite du matériel capable d'effectuer des millions d'opérations en parallèle, même si la puissance de calcul dédiée à chacune d'entre elles est relativement faible.

Heureusement, il s'agit d'un type de matériel qui fonctionne déjà depuis de nombreuses années, comme le rendu graphique à l'aide de GPU, principalement pour la simulation 3D et les jeux vidéo, et qui utilise également ce type de nombreux petits calculs en parallèle.

C'est pourquoi le vainqueur initial (et actuel) de la course à l'obtention d'un nombre suffisant de puces d'IA a été Nvidia, le leader du marché des GPU.

Des GPU toujours plus rapides

Avec l'invention d'algorithmes plus efficaces et les progrès rapides de l'intelligence artificielle qui en découlent, les applications potentielles de l'IA ont explosé dans les années 2020.

Cela a conduit à une course de plus en plus intense pour obtenir suffisamment de matériel, en particulier les GPU de Nvidia en 2023.

Parallèlement, les attentes croissantes des applications potentielles de l'IA requièrent une IA toujours plus intelligente, ce qui nécessite une plus grande puissance de calcul. Si l'augmentation du nombre de GPU est une solution, il faut aussi de meilleurs GPU.

L'industrie a répondu à l'appel, en multipliant par 1 000 les performances en moins de 8 ans.

Source : NVIDIA

Est-ce que cela peut durer ?

Certains signes indiquent que les progrès en matière de performances des GPU pourraient bientôt ralentir. Tout d'abord, toutes les améliorations "faciles", telles que l'augmentation de la taille des GPU et l'utilisation de transistors plus petits et plus denses, sont en train de s'épuiser. Par conséquent, les améliorations futures doivent provenir de conceptions et d'innovations plus radicales.

L'industrie est également confrontée à des problèmes secondaires. Par exemple, les GPU beaucoup plus denses et puissants produisent beaucoup de chaleur résiduelle, à tel point qu'une augmentation de cette chaleur ferait tout simplement fondre les puces.

Cette chaleur perdue est également le signe d'une grande quantité d'énergie gaspillée. Garantir un approvisionnement suffisant en énergie de base stable devient un problème pour les entreprises d'IA, toutes les grandes entreprises technologiques s'empressent de s'approvisionner auprès des centrales nucléaires.

Enfin, l'informatique de l'IA devient plus spécialisée, avec différentes méthodologies émergeant dans différentes entreprises et pour différentes applications, chacune ayant des exigences différentes en ce qui concerne son matériel. Il est donc fort probable que l'ère des GPU polyvalents utilisés par toutes les entreprises d'IA touche à sa fin, même si c'est lentement.

L'ère des super GPU

Jusqu'à présent, la plupart des centres de données d'IA consistaient à relier des milliers de GPU à des serveurs dédiés.

La solution immédiate au problème croissant de surchauffe et de consommation d'énergie sera la construction d'un matériel intégré allant au-delà de l'accumulation de GPU individuels.

Un pas important dans cette direction a été franchi avec la récente publication par Nvidia de GB200 NVL72. Ce matériel est conçu pour agir comme un seul GPU massif, ce qui le rend beaucoup plus puissant que le modèle H100, qui avait déjà battu des records.

Ce système devrait également être beaucoup plus économe en énergie, un point crucial car l'industrie de l'IA risque de manquer d'énergie avant de manquer de puces à la vitesse à laquelle les centres de données de l'IA sont construits. Et plus de calcul et d'efficacité énergétique signifient moins de chaleur perdue, ce qui résout aussi temporairement le problème de la surchauffe.

Source : Nvidia

Actuellement, CoreWeave est devenu le premier fournisseur de services en nuage à disposer d'une solution Nvidia GB200 NLV72 instances.

(Pour en savoir plus sur CoreWeave et sa fourniture d'informatique en nuage pour l'IA aux entreprises qui développent des solutions d'IA, voir "CoreWeave : L'hyperscaler d'IA dans le nuage").

Matériel d'IA sans GPU

Réseaux de portes programmables (FPGA)

Un autre type de matériel utilisé pour le développement de l'IA est le Field-Programmable Gate Arrays (FGPA). Les FGPA sont des circuits intégrés qui peuvent être reprogrammés pour effectuer des tâches spécifiques plus efficacement. Ils fonctionnent grâce à des interconnexions configurables entre leurs composants.

Source : Laboratoires de microcontrôleurs

Les FPGA sont donc plus flexibles que les GPU et offrent davantage de possibilités d'optimisation pour des types de calculs spécifiques.

Les FPGA sont également plus économes en énergie que les GPU. Leur faible latence (temps de réaction rapide) les rend également très efficaces pour les applications réelles nécessitant des réactions rapides.

Toutefois, les FPGA sont également moins aptes à effectuer des calculs très exigeants qui nécessitent beaucoup d'énergie.

Un autre problème est que, bien que les FPGA soient reprogrammables, ce processus peut nécessiter beaucoup de temps et de main-d'œuvre. Ils peuvent donc être beaucoup plus lents à concevoir, à construire et à programmer. Cela peut être un problème sérieux dans un domaine qui fait des progrès révolutionnaires tous les six mois.

Cela signifie que jusqu'à présent, Les cas d'utilisation des FGPA se sont concentrés sur certaines applications de l'IALe développement général s'appuie toujours sur des GPU moins efficaces, mais polyvalents :

- Traitement en temps réel : Wes données entrantes doivent être traitées rapidement, par exemple pour le traitement des signaux numériques, les systèmes radar, les véhicules autonomes et les télécommunications.

- Accélération matérielle personnalisée : Les FPGA configurables peuvent être finement réglés pour accélérer des tâches spécifiques d'apprentissage profond et des clusters HPC en optimisant pour des types de données ou des algorithmes spécifiques.

- Ainsi, les centres de données d'IA modernes pourraient progressivement devenir un mélange de GPU et de FPGA, chaque matériel étant dédié aux sous-tâches qu'il est le mieux à même de réaliser.

- Informatique de pointe : Les capacités de calcul et de stockage sont ainsi rapprochées de l'utilisateur final, par exemple directement dans une voiture ou un drone. Dans ces cas, la faible consommation d'énergie et la taille compacte des FPGA sont des avantages.

Circuits intégrés à application spécifique (ASIC)

Les systèmes ASIC sont conçus pour des types de calculs spécifiques et ne peuvent effectuer que ceux-ci. Il ne s'agit donc pas tant d'une puce informatique que d'un pur circuit intégré ; les FPGA sont parfois également appelés ASIC programmables.

La raison d'utiliser des ASIC plutôt que des FPGA ou des GPU est que les ASIC sont beaucoup plus rapides que n'importe quel autre dispositif logique. Ils sont également plus économes en énergie et plus petits.

C'est pourquoi, par exemple, les mineurs ASIC sont utilisés pour l'extraction de crypto-monnaies, leur conception étant optimisée pour effectuer le type de calcul spécifique requis.

Source : Wevolver

Toutefois, les ASIC sont également beaucoup plus complexes à concevoir, de sorte qu'il n'est judicieux d'en développer un que pour une tâche qui sera répétée suffisamment souvent pour couvrir les coûts de conception. Dans l'ensemble, les ASIC n'ont de sens économique que lorsqu'ils sont envisagés pour une production de masse.

Les conceptions personnalisées nécessitent également des connaissances spécialisées, et les langages de programmation et les bibliothèques couramment utilisés ne sont potentiellement pas utilisables.

Cette nécessité d'une conception sur mesure peut toutefois constituer un avantage, car elle crée une protection supplémentaire de la propriété intellectuelle (PI).

Les cas d'utilisation des ASIC sont similaires à ceux des FPGA : edge computing, reconnaissance d'images, télécommunications et traitement du signal, mais plus encore que les FPGA, ils nécessitent un calcul souvent répété.

Comme ils ne sont pas flexibles, il est peu probable qu'ils suffisent à eux seuls à réaliser des tâches d'IA complexes. Ils pourraient toutefois être intégrés dans un système matériel d'IA pour lui donner plus d'efficacité et de rapidité.

Notamment, des entreprises comme Gravé se développent ASICs spécifiquement conçus pour effectuer le calcul des transformateurs (le "T" de chatGPT).

Source : Gravé

Puces neuromorphiques

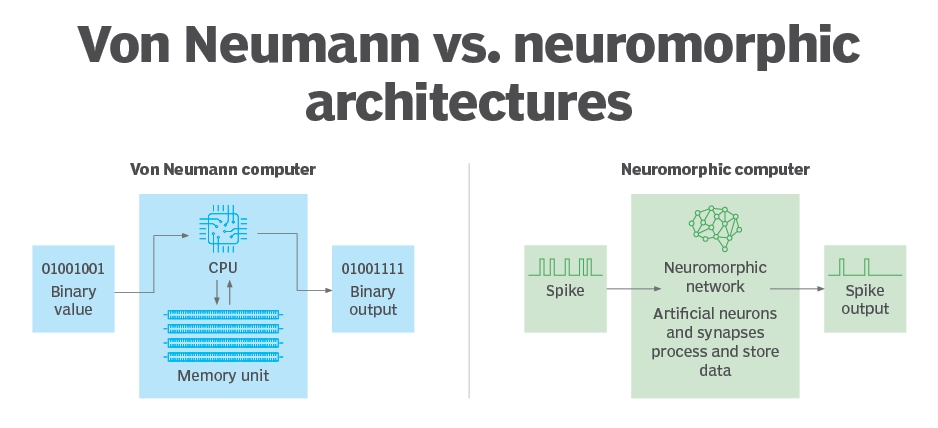

Au-delà de l'amélioration des GPU ou de la construction d'ASIC plus efficaces, d'autres concepts visent à modifier complètement la manière dont les calculs sont effectués.

L'une des idées est que si nous concevons un réseau neuronal, nous devrions avoir une architecture de puce qui le reflète.

C'est l'idée des puces neuromorphiques, qui fonctionnent comme des neurones interconnectés au niveau matériel au lieu de les simuler au moyen d'équations mathématiques complexes et de millions de calculs parallèles.

Ces dispositifs sont aussi parfois appelés NPUs (Neural Processing Unit)La plupart du temps, il s'agit d'une combinaison de plusieurs types de composants différents en une seule unité.

Les puces neuromorphiques utilisent souvent des signaux électriques complexes, plus proches des données analogiques. Cela diffère des ordinateurs "normaux" qui utilisent une conception Von Neumann avec des signaux binaires (0 et 1).

Source : Cible technologique

De nombreuses méthodes sont actuellement explorées pour créer des puces neuromorphiques :

- Tirer parti de la ferroélectricité naissanteun phénomène encore mal compris.

- Substrat actif utilisant du vanadium ou du titane.

- Utilisation des memristorsun nouveau type de composant électronique, qui peut effectuer des tâches d'intelligence artificielle à 1/800thde la consommation électrique normale.

Puces photoniques

Une autre option pour contourner les limitations actuelles du matériel en silicium est de passer à la technologie ordinateurs photoniques. Ce ne sont pas les électrons qui transportent l'information, mais les photons des lasers.

Cette méthode présente l'avantage d'être beaucoup moins vulnérable à la surchauffe et de permettre à la lumière de se déplacer le plus rapidement dans l'univers.

Jusqu'à présent, la durabilité des composants photoniques, notamment des mémoires, a posé problème, mais la situation évolue rapidement.

Parmi les autres progrès récents dans le domaine de la photonique, on peut citer

- Transistor ferroélectrique à haute mobilité électronique (FeHEMT)les dispositifs de communication de plus en plus petits sur les smartphones.

- Les pérovskites, plus précisément CsPbBr3 (bromure de césium et de plomb)cristauxLa technologie de la photonique, qui mélange la photonique avec des substrats "normaux" de silicium et d'arséniure de gallium, est en cours d'élaboration.

- Écriture laser ultra-rapidepour concevoir des composants photoniques à l'aide de la nanogravure.

- Méthode de fabrication de photonique multicouche au silicium.

- Utilisation de la magnétite pour créer des ordinateurs spintroniques-photoniques.

Utiliser des neurones réels

Une autre façon de pousser l'IA à atteindre des performances similaires à celles du cerveau est peut-être tout simplement d'utiliser des cerveaux.

Après tout, si un réseau neuronal composé de véritables neurones peut être très adaptatif et exceller dans la reconnaissance des formes dans la nature, pourquoi ne fonctionnerait-il pas dans un contexte plus artificiel ?

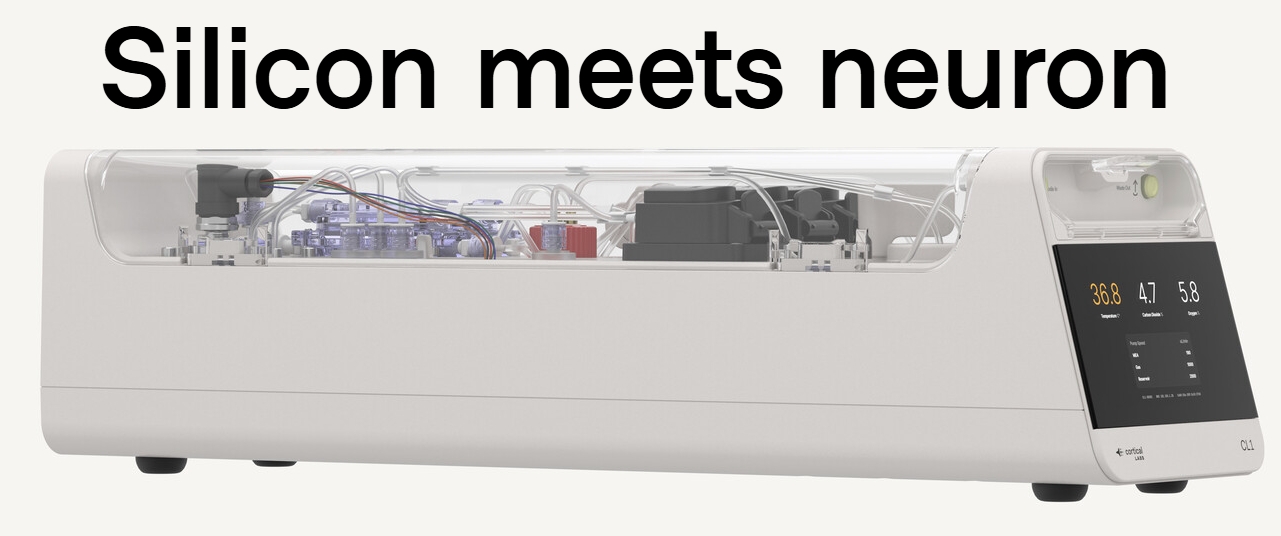

En mars 2025, ce concept a évolué avec la publication par Laboratoires Cortical de CL1Le premier système d'intelligence biologique synthétique (SBI).

Source : Laboratoires Cortical

De vrais neurones sont cultivés dans une solution riche en nutriments, qui leur fournit tout ce dont ils ont besoin pour être en bonne santé. Ils se développent sur une puce de silicium, qui envoie et reçoit des impulsions électriques dans la structure neuronale.

Cela brouille véritablement la frontière entre l'intelligence artificielle et l'intelligence naturelle. Un ordinateur composé de véritables neurones est-il encore artificiel ?

Nous intégrons les neurones dans le biOS à l'aide d'un mélange de silicium dur et de tissu mou. Vous pouvez vous connecter directement à ces neurones. Déployez du code directement sur les vrais neurones et relevez les défis les plus difficiles d'aujourd'hui.

Le neurone est autoprogrammé, infiniment flexible et le résultat de quatre milliards d'années d'évolution. Ce que les modèles d'IA numérique consacrent d'énormes ressources à essayer d'imiter, nous le commençons.

Il pourrait s'agir d'une véritable percée si certaines théories considérant le cerveau humain comme un ordinateur quantique plutôt qu'un système électrique s'avèrent exactes.

Bien qu'il s'agisse encore d'une technologie émergente, elle pourrait être stimulée par les progrès réalisés dans les champs afférents, tels que le champ d'application de l'énergie solaire et le champ d'application de l'énergie nucléaire. Impression 3D d'organes humains, y compris tissu cérébral fonctionnelainsi que le production d'organoïdes (mini-cerveaux) par des entreprises telles que L'étincelle finale et BiologIC.

Interface cerveau-ordinateur

Un autre moyen de stimuler le matériel d'IA pourrait être de l'utiliser en interface directe avec un autre type de superordinateur biologique : le cerveau qui se trouve déjà dans notre crâne et qui nous fait réfléchir.

Dans un premier temps, les interfaces cerveau-ordinateur (ICU) seront vraisemblablement principalement utilisé pour aider les personnes souffrant de troubles neurologiques.

Nouvelles méthodes de fabrication les implants sont plus durables et moins invasifs devrait également être utile.

À long terme, cela pourrait également brouiller la frontière entre l'intelligence humaine et l'intelligence de la machine. Si vous pensez à quelque chose avec l'aide d'une IA en interaction directe avec nous par l'intermédiaire d'un BCI, qui a pensé exactement ?

Cependant, en raison de problèmes d'éthique et de sécurité, il s'agit probablement de l'une des technologies les plus lointaines, malgré l'anticipation d'œuvres de science-fiction telles que Altered Carbon, Neuromancienou Cyberpunk 2077.

(Nous avons présenté les entreprises les plus importantes dans ce domaine dans "5 meilleures entreprises d'interfaces cerveau-ordinateur (BCI)").

Quelle est la quantité de calcul réellement nécessaire ?

DeepSeek

Depuis de nombreuses années, toutes les entreprises spécialisées dans l'IA se sont lancées dans une course à l'augmentation de la capacité de calcul le plus rapidement possible, en partant du principe que plus c'est mieux c'est.

Cela a été contesté par l'arrivée brutale de l'entreprise chinoise d'IA DeepSeek. Avec un modèle 10 à 100 fois plus efficace que ses concurrents, et ne coûtant que 3%-5% pour des performances équivalentes ou supérieures, DeepSeek a remis en question la nécessité d'augmenter la puissance de calcul pour construire de meilleures IA.

Si DeepSeek s'est autant concentré sur l'efficacité des modèles, c'est en grande partie à cause de l'accès limité des entreprises d'IA chinoises aux puces d'IA. Cela est apparu clairement lorsqu'il a été révélé, peu après le lancement, que les modèles d'IA d'autres entreprises chinoises étaient tout aussi performants : Qwen d'Alibaba, Kimi de Moonshot AI, Doubao de ByteDance ou Ernie Bot de Baidu.

Comme le dit le proverbe, "la nécessité est la mère de l'invention".

Il est probable qu'au cours des prochaines années, l'industrie de l'IA sera dominée par un double souci d'amélioration des performances et de l'efficacité.

Toutefois, cela ne veut pas dire qu'un plus grand nombre de calculs ne donnera pas de meilleurs résultats. Simplement, ce n'est pas le cas. seulement Les entreprises très bien financées, comme OpenAI, ont peut-être été un peu moins rigoureuses dans leurs dépenses.

Pour l'instant, la plupart des IA sont des travaux en cours et des modèles expérimentaux dont les applications sont limitées. Plus elles seront intégrées dans le flux de travail de millions d'entreprises dans le monde, plus l'informatique de l'IA sera nécessaire.

Et plus les besoins informatiques augmentent, plus la demande de matériel plus efficace et moins gourmand en énergie augmente.

Comme pour l'informatique traditionnelle, nous pouvons supposer que le marché continuera à exiger des puces toujours plus performantes, d'autant plus que l'IA pourrait bientôt devenir l'un des plus gros consommateurs d'énergie au monde.

EdgeAI et PC IA

Un autre effet de l'émergence de DeepSeek et d'autres modèles chinois d'IA moins gourmands en ressources informatiques est que les modèles d'IA, en particulier les modèles "distillés", peuvent désormais fonctionner sur des machines individuelles haut de gamme, au lieu de centres de données géants d'IA d'une capacité de plusieurs gigawatts.

Cela donne raison aux partisans de l'EdgeAI, qui estiment qu'une grande partie de l'informatique de l'IA doit être réalisée "sur place", et non pas uniquement dans le nuage.

DeepSeek étant un modèle open-source, il ouvre également la voie à de nombreuses expériences individuelles avec des ordinateurs d'IA : suffisamment puissants pour exécuter des modèles d'IA, mais suffisamment bon marché et petits pour être achetés par des particuliers. Dans l'ensemble, cela ne conduit pas tant à une diminution de la demande d'ordinateurs d'IA qu'à un processus plus décentralisé de développement et d'utilisation d'applications d'IA.

Les PC IA sont donc susceptibles d'être la nouvelle grande tendance en matière de construction d'ordinateurs, La presse spécialisée discute déjà en détail de la question et de la marque la plus appropriée. d'autant plus que l'IA fait son chemin dans l'offre de la plupart des entreprises technologiques, y compris Microsoft (MSFT -1.98%)Copilot devient presque omniprésent dans le système d'exploitation Windows et dans d'autres logiciels de l'entreprise.

Conclusion

Le matériel destiné à l'IA évolue rapidement depuis les GPU de jeu. Cela a commencé par des GPU conçus pour l'IA et évolue avec des "super GPU" conçus à partir de zéro pour s'intégrer dans les centres de données d'IA avec une consommation d'énergie et une production de chaleur moindres.

La prochaine étape consistera probablement à intégrer davantage les GPU généralistes aux ASIC et aux puces FGPA afin d'exécuter des tâches d'IA spécifiques avec des besoins moindres en termes de puissance et d'espace.

À plus long terme, les paris portent sur la technologie qui sera la plus performante pour l'informatique de l'IA : puces neuromorphiques, photonique, spintronique, voire de véritables neurones biologiques entraînés à interagir avec des substrats de silicium, et peut-être une IA interagissant directement avec notre propre cerveau par le biais d'interphases directes.

Pour toutes ces technologies, il est certain que la croissance explosive des capacités de l'IA et la croissance explosive des applications qui l'accompagne feront croître la demande de matériel d'IA plus important et de meilleure qualité.

Ainsi, même si des modèles d'IA plus efficaces arrivent sur le marché, comme DeepSeek, la soudaine ruée sur les PC d'IA pourrait être un bon indicateur du fait que l'offre de matériel d'IA restera probablement assez faible par rapport à la demande dans les années à venir.

Un leader dans le domaine du matériel d'IA

Nvidia

NVIDIA Corporation (NVDA -3.65%)

NVIDIA est passée d'une société de semi-conducteurs de niche spécialisée dans les cartes graphiques à un géant de la technologie à l'avant-garde de la révolution de l'IA et de l'énorme quantité de matériel qu'elle nécessite.

Ce résultat a été obtenu grâce au développement de CUDA, une interface de programmation à usage général pour les GPU de NVIDIA, qui ouvre la voie à d'autres utilisations que les jeux.

"Les chercheurs ont réalisé qu'en achetant cette carte de jeu appelée GeForce, vous l'ajoutez à votre ordinateur et vous disposez essentiellement d'un superordinateur personnel. Dynamique moléculaire, traitement sismique, reconstruction de tomodensitométrie, traitement d'images - tout un tas de choses différentes.

Cette adoption plus large des GPU, et plus particulièrement du matériel NVIDIA, a créé une boucle de rétroaction positive basée sur les éléments suivants les effets de réseauPlus il y aura d'utilisations, plus il y aura d'utilisateurs finaux et de programmeurs qui le connaîtront, plus il y aura de ventes, plus il y aura de budget R&D, plus il y aura d'accélération de la vitesse de calcul, plus il y aura d'utilisations, etc.

Source : Nvidia

Aujourd'hui, la base installée comprend des centaines de millions de GPU CUDA.

Un autre aspect remarquable de l'évolution de la puissance de calcul de l'IA est qu'elle suit une loi exponentielle au lieu de la loi de Moore, plus linéaire, pour les processeurs. En effet, non seulement le matériel GPU s'améliore, mais la puissance de traitement nécessaire a diminué grâce à l'amélioration radicale de la formation des réseaux neuronaux.

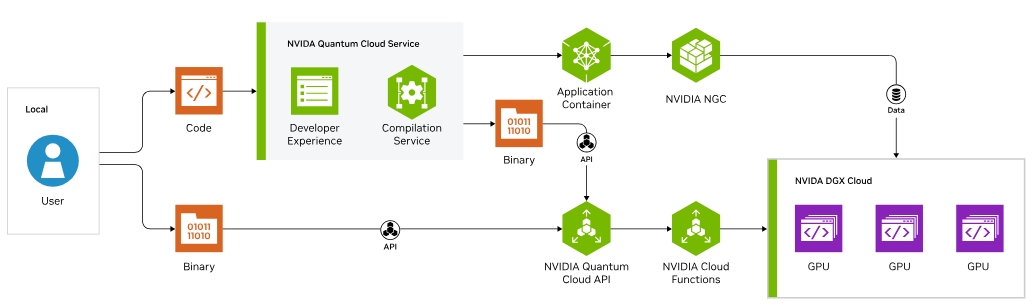

Tout en étant un leader dans le domaine des GPU et de l'IA, NVIDIA est également très active dans le développement de l'informatique quantique pour en faire un nouveau moteur de croissance..

De la même manière qu'elle a déployé CUDA pour les applications de réseaux neuronaux, Nvidia a lancé CUDA-Q pour l'informatique quantique, proposant un système de cloud quantique dans lequel vous pouvez louer la capacité d'informatique quantique de NVIDIA par le biais d'un service de cloud.

Source : NVIDIA

Il s'agit également de technologies telles que cuQuantum de NVIDIA, qui permet aux chercheurs d'émuler des ordinateurs quantiques, cuPQC pour le cryptage quantique et DGX Quantum pour l'intégration de l'informatique classique et quantique.

Dans l'ensemble, NVIDIA est à l'avant-garde de la construction d'un écosystème d'informatique quantique, capitalisant sur sa position de leader en matière d'IA et de matériel d'IA.

Source : NVidia

Avec une position forte dans l'IA, le minage de crypto-monnaies et peut-être bientôt l'informatique quantique, Nvidia est très bien positionnée pour être l'une des entreprises dominantes dans le domaine du matériel informatique au cours de la prochaine décennie.

Pour en savoir plus sur l'histoire, le modèle d'entreprise et les innovations de Nvidia, consultez le site "Pleins feux sur NVIDIA (NVDA) : Du géant du graphisme au titan de l'IA".