الذكاء الاصطناعي

الاستثمار في أجهزة الذكاء الاصطناعي: من وحدات المعالجة المركزية إلى وحدات معالجة الرسومات XPU

تلتزم Securities.io بمعايير تحريرية صارمة، وقد تتلقى تعويضات عن الروابط المُراجعة. لسنا مستشارين استثماريين مُسجلين، وهذه ليست نصيحة استثمارية. يُرجى الاطلاع على كشف التابعة لها.

الاستثمار في أجهزة الذكاء الاصطناعي: نهجٌ عملي

ومن المتوقع أن يكون الذكاء الاصطناعي التغيير الأكثر أهمية في اقتصادنا وأنظمتنا الإنتاجية ومجتمعنا خلال العقود القليلة الماضية، مما قد يجعل حتى التغييرات الجذرية التي جلبها الإنترنت تافهة بالمقارنة.

قد يؤدي ذلك إلى اختفاء فئة كاملة من الوظائف، بما في ذلك السائقون والمترجمون ودعم العملاء ومصممو المواقع الإلكترونية، وما إلى ذلك. وقد تشهد وظائف أخرى انخفاضًا جذريًا في الطلب، مثل المبرمجين والمحامين المبتدئين وأخصائيي التشخيص، وما إلى ذلك.

ومن المتوقع أيضًا أن يخلق ذلك قدرًا كبيرًا من القيمة الإضافية والإنتاجية للعديد من المهام الأخرى، حيث من المرجح أن تكون شركات برمجيات الذكاء الاصطناعي المهيمنة هي الأولى التي تصل إلى قيم سوقية لم يكن من الممكن تصورها من قبل.

ولهذه الأسباب كلها، أصبحت أسواق رأس المال والمستثمرون مفتونين بالذكاء الاصطناعي، وأولوا قدرًا كبيرًا من الاهتمام لتقدم العديد من شركات التكنولوجيا العملاقة في مجال الذكاء الاصطناعي، فضلاً عن المنافسة القوية الناشئة من شركات التكنولوجيا الصينية العملاقة مثل علي بابا والشركات الناشئة مثل ديب سيك.

طريقة أخرى للاستفادة من طفرة الذكاء الاصطناعي هي اتباع الاستراتيجية المعروفة في كل طفرة ذهبية: لا تبحث عن الذهب، بل بِع المعاول والمجارف. وقد نجحت هذه الاستراتيجية بالتأكيد مع الشركات التي كانت في أفضل وضع لبيع الأجهزة المُحسّنة للذكاء الاصطناعي، مع NVIDIA (NVDA -0.79٪) بعد أن حولت بطاقات الرسوميات الخاصة بالألعاب إلى شرائح تدريب الذكاء الاصطناعي، مما جعلها الشركة الأكثر قيمة في العالم، بعد أن تجاوزت القيمة السوقية المذهلة البالغة 4 تريليون دولار (اتبع الرابط للحصول على تقرير كامل عن Nvidia).

وبما أن الذكاء الاصطناعي يتطلب أجهزة محددة للغاية، وتختلف في معظمها عن أشكال أخرى سابقة من مهام الحوسبة، ويشكل فرصة عمل هائلة، فإن صناعة أشباه الموصلات الآن في سباق لتطوير أشكال جديدة من الأجهزة المصممة خصيصا لتدريب وتشغيل برامج الذكاء الاصطناعي.

وفي حين من المرجح أن تظل شركة Nvidia واحدة من الشركات الرائدة في القطاع، فإن البدائل بدأت تظهر الآن ويمكن أن توفر فرصًا مثيرة للاهتمام للمستثمرين الذين ينتبهون في وقت مبكر.

لماذا يحتاج الذكاء الاصطناعي إلى أجهزة متخصصة

العديد من الحسابات الصغيرة

استخدمت الجهود الأولية في مجال الذكاء الاصطناعي نفس سعة الحوسبة المستخدمة في البرامج الأخرى، مع التركيز بشكل رئيسي على المعالجات (وحدات المعالجة المركزية). لا تزال وحدات المعالجة المركزية مهمة، ولكن سرعان ما اتضح أنها ليست الأمثل لمعظم الأساليب المستخدمة حاليًا لتطوير الذكاء الاصطناعي.

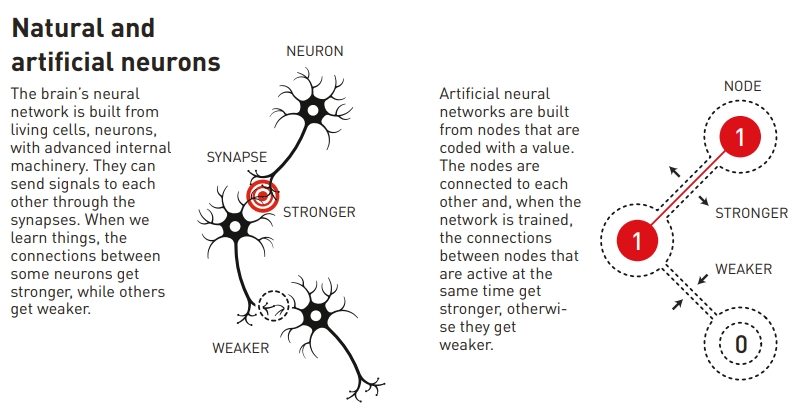

تتطلب الشبكات العصبية والأساليب المشابهة لها العديد من الحسابات البسيطة نسبيًا، بدلًا من عملية حسابية واحدة معقدة للغاية. يُعدّ استخدام العديد من الرقائق الصغيرة بالتوازي أفضل من استخدام وحدات المعالجة المركزية الضخمة والقوية.

وهذا هو السبب الرئيسي وراء الشعبية الكبيرة التي اكتسبتها وحدات معالجة الرسوميات، حيث تم تصميم بطاقات الرسوميات بطبيعتها لأداء آلاف العمليات الحسابية الأصغر بالتوازي.

يعتمد تدريب الذكاء الاصطناعي اليوم إلى حد كبير على الشبكات العصبية، مفهوم فاز بجائزة نوبل في الفيزياء عام 2024، وهي الجائزة التي تناولناها بالتفصيل في مقال مخصص في ذلك الوقت.

المصدر جائزة نوبل

جاءت ثورة ثانية في تكنولوجيا الذكاء الاصطناعي مع "المحولات". فهي تحل مشاكل الشبكات العصبية التقليدية. عدم القدرة على معالجة تسلسلات طويلة من البيانات بكفاءة، وهي سمة مشتركة لأي لغة طبيعية.

طُرح هذا المفهوم لأول مرة عام ٢٠١٧ من قِبل باحثي جوجل، وهو السبب الرئيسي للطفرة الحالية في قدرات الذكاء الاصطناعي. تُشكّل المحوّلات جوهر منتجات الذكاء الاصطناعي، مثل نماذج اللغات الكبيرة (LLMs)، بما في ذلك ChatGPT.

متطلبات مختلفة

أحد أهم الفروقات في سير عمل الذكاء الاصطناعي هو الفرق بين الكون المثالى والاستدلال، وكلاهما له متطلبات أجهزة مميزة.

- الكون المثالى يتضمن تدريب نموذج على بيانات خاصة بمجال معين، ويتطلب قوة حوسبة وذاكرة كبيرتين. إنها مهمة تقنية للغاية، وغالبًا ما تكون في صميم علم الذكاء الاصطناعي.

- الإستنباط يركز على استخدام نموذج مدرب بالفعل لتوليد المخرجات، مما يتطلب طاقة حسابية أقل ولكن مع التركيز بشكل أكبر على زمن الوصول المنخفض والكفاءة من حيث التكلفة.

- ويتم ذلك بشكل روتيني أكثر من قبل خبراء الذكاء الاصطناعي الذين ينشرون نماذج موجودة مسبقًا لحل مشاكل الحياة الواقعية.

لذا، في حين أن التكاليف تشكل بوضوح مصدر قلق لكل من الضبط الدقيق/التدريب والاستدلال/استخدام الذكاء الاصطناعي، فإن التدريب يتطلب غالبًا أفضل الأجهزة الممكنة، في حين ستركز مهام الاستخدام بشكل أكبر على تكلفة الأجهزة واستهلاك الطاقة عند اختيار أفضل خيار للأجهزة.

وحدات المعالجة المركزية مقابل وحدات معالجة الرسومات

وحدات المعالجة المركزية (CPUs):

وحدات المعالجة المركزية (CPUs) عامة الاستخدام وليست مخصصةً للذكاء الاصطناعي. مع ذلك، فهي ضرورية لتنفيذ التعليمات وإجراء العمليات الحسابية الأساسية في أنظمة الذكاء الاصطناعي.

ستكون معظم البرامج التي تتعامل مع الواجهة مع المستخدمين النهائيين لنظام الذكاء الاصطناعي أيضًا متمحورة حول وحدة المعالجة المركزية، سواء كانت أجهزة كمبيوتر فردية أو برامج تعتمد على السحابة.

المصدر AnandTech

يمكن استخدام وحدات المعالجة المركزية أيضًا في أنظمة الذكاء الاصطناعي البسيطة جدًا، حيث لا تتطلب أجهزة مخصصة. وينطبق هذا بشكل خاص عندما لا يكون الناتج عاجلاً للغاية، ولا تُشكل معالجة الذكاء الاصطناعي البطيئة نسبيًا لوحدات المعالجة المركزية مشكلة.

لذا، يمكن للنماذج الصغيرة ذات دفعات البيانات والحسابات الصغيرة أن تعمل بشكل جيد على وحدات المعالجة المركزية. كما أن انتشار وحدات المعالجة المركزية في أجهزة الكمبيوتر العادية يجعلها خيارًا جيدًا للمستخدم العادي الذي لا يرغب في الاستثمار في أجهزة مخصصة للذكاء الاصطناعي.

كما أن وحدات المعالجة المركزية موثوقة للغاية ومستقرة، مما يجعلها خيارًا جيدًا للمهام الحرجة حيث لا يكون الخطأ معيارًا مهمًا.

أخيرًا، تُعد وحدات المعالجة المركزية مفيدة لبعض المهام في تدريب الذكاء الاصطناعي، وعادةً ما يتم ذلك بالتعاون مع أنواع أخرى من الأجهزة، مثل تحميل البيانات، والتنسيق، والتصفية، والتصور.

وحدات معالجة الرسومات (GPUs):

صُممت وحدات معالجة الرسومات (GPUs) في الأصل لعرض الرسومات، وهي مصممة للمعالجة المتوازية، مما يجعلها مثالية لتدريب نماذج الذكاء الاصطناعي التي تتطلب معالجة مجموعات بيانات ضخمة. وقد أدى التحول من وحدات المعالجة المركزية (CPUs) إلى وحدات معالجة الرسومات (GPUs) إلى تقليص أوقات التدريب من أسابيع إلى ساعات.

بفضل توفرها على نطاق واسع وخبرة المتخصصين في تكنولوجيا المعلومات في العمل معها، كانت وحدات معالجة الرسومات هي أول نوع من أجهزة الحوسبة التي يتم تثبيتها على التوالي لتوسيع نطاق أبحاث الذكاء الاصطناعي.

المصدر Aorus

كان من العوامل الأساسية لنجاح وحدات معالجة الرسومات تطويرُ CUDA من قِبل شركة Nvidia، وهي واجهة برمجة عامة لوحدات معالجة الرسومات من Nvidia، مما فتح الباب لاستخدامات أخرى غير الألعاب. وقد حدث ذلك لأن بعض الباحثين كانوا يستخدمون بالفعل وحدات معالجة الرسومات لإجراء الحسابات بدلاً من الحواسيب العملاقة المعتادة.

"أدرك الباحثون أنه من خلال شراء بطاقة الألعاب هذه المسماة GeForce، وإضافتها إلى جهاز الكمبيوتر الخاص بك، فإنك تمتلك في الأساس جهاز كمبيوتر عملاق شخصي.

"الديناميكيات الجزيئية، والمعالجة الزلزالية، وإعادة بناء التصوير المقطعي المحوسب، ومعالجة الصور - مجموعة كاملة من الأشياء المختلفة."

واليوم، لا تزال وحدات معالجة الرسومات من بين أكثر أنواع أجهزة الذكاء الاصطناعي طلبًا، حيث بالكاد تتمكن شركة Nvidia من إنتاج ما يكفي لتلبية طلب شركات التكنولوجيا العملاقة التي تبني مراكز بيانات الذكاء الاصطناعي بمقياس الجيجاواط.

إنها أيضًا بداية "عصر وحدة معالجة الرسومات الفائقة"، مع الإصدار الأخير لشركة Nvidia GB200 NVL72.

صُمم هذا الجهاز ليعمل كوحدة معالجة رسومية ضخمة واحدة مباشرة من المصنع، بدلاً من ربط العديد من الوحدات الصغيرة عبر شبكة. وهذا يجعله أقوى بكثير من طراز H100 الذي حطم الأرقام القياسية سابقًا.

المصدر NVIDIA

من المفترض أيضًا أن يكون هذا أكثر كفاءة في استخدام الطاقة، وهي نقطة حاسمة، إذ قد تعاني صناعة الذكاء الاصطناعي من نقص في الطاقة قبل أن تعاني من نقص في الرقاقات بالسرعة التي تُبنى بها مراكز بيانات الذكاء الاصطناعي. كما أن زيادة كفاءة الحوسبة والطاقة تعني انخفاضًا في الحرارة المهدرة، مما يحل مشكلة ارتفاع درجة الحرارة مؤقتًا.

| نوع الجهاز | أفضل حالة استخدام | سرعة | كفاءة إستهلاك الطاقة | المرونة |

|---|---|---|---|---|

| وحدة المعالجة المركزية: | المهام العامة | منخفض | مرتفع | عالي جدا |

| وحدة معالجة الرسوميات: | تدريب الذكاء الاصطناعي والمهام الموازية | مرتفع | متوسط | متوسط |

| TPU | عمليات الموتر والمحولات | عالي جدا | مرتفع | منخفض |

| أسيك | تسريع المهمة الفردية | عالي جدا | عالي جدا | منخفظ جدا |

| FPGA | أحمال عمل الذكاء الاصطناعي القابلة لإعادة التكوين | متوسط | متوسط | مرتفع |

صعود ASICs وأجهزة الذكاء الاصطناعي

الدوائر المتكاملة المخصصة للتطبيق (ASICs) هي أجهزة حاسوبية مصممة خصيصًا لمهمة حوسبة معينة، مما يجعلها أكثر تخصصًا من وحدات معالجة الرسومات العامة نسبيًا.

لذا فهي أقل مرونة وقابلية للبرمجة من الأجهزة العامة.

وكقاعدة عامة، تميل هذه المنتجات إلى أن تكون أكثر تعقيدًا. كما أنها أكثر تكلفةً عمومًا، نظرًا لقلة اقتصاديات الحجم لإنتاجها وتكلفة التصاميم المخصصة.

ومع ذلك، فهي أكثر كفاءة في أداء المهمة الموكلة إليها، وعادةً ما تنتج نتائج أسرع مع إهدار قدر أقل بكثير من طاقة الحوسبة والطاقة.

تتزايد معدلات استخدام ASICs وغيرها من الأجهزة المخصصة للذكاء الاصطناعي، حيث يلاحظ المجال بشكل متزايد أن بعض الحسابات لا تتم بشكل مثالي على وحدات معالجة الرسومات (GPU) ولكنها تتطلب معدات أكثر تخصصًا.

وحدات معالجة الموتر (TPUs)

تم تطوير TPUs بواسطة Google (GOOGL -1.77٪) مصممة خصيصًا لإجراء حسابات الموتر (المرتبطة بحساب التفاضل والتكامل القائم على المحولات). وهي مُحسّنة لعمليات حسابية عالية الإنتاجية ومنخفضة الدقة.

المصدر زاوية سي شارب

يمنح هذا وحدات TPU أداءً عاليًا وكفاءة وقابلية للتوسع لتدريب الشبكات العصبية الكبيرة.

تتمتع وحدات معالجة المواد (TPU) بميزات متخصصة، مثل وحدة مضاعفة المصفوفة (MXU) وطوبولوجيا الترابط الملكية، مما يجعلها مثالية لتسريع تدريب الذكاء الاصطناعي والاستدلال.

تعمل وحدات TPU على تشغيل نظام Gemini وجميع تطبيقات Google المدعومة بالذكاء الاصطناعي مثل البحث والصور والخرائط، والتي تخدم أكثر من مليار مستخدم.

يمكن لهذا النوع من الأجهزة تسريع تطوير وعمل الشبكات العصبية بشكل كبير، حيث يكون الخطأ العرضي أقل أهمية، حيث تعتمد هذه النماذج بشكل كبير على الإحصائيات وعدد كبير من الحسابات في البداية.

من بين مهام المستخدم النهائي الأكثر ملاءمة لوحدات المعالجة المركزية التعلم العميق والتعرف على الكلام وتصنيف الصور.

معالجات الشبكات العصبية (NNPs):

ترتبط وحدات المعالجة العصبية (NPUs) أيضًا بوحدات المعالجة العصبية (NPUs)، وتُسمى الرقائق العصبية الشكلية، وهي متخصصة في حوسبة الشبكات العصبية، وهي مصممة لمحاكاة الروابط العصبية في الدماغ البشري. وتُسمى أحيانًا مُسرّع الذكاء الاصطناعي، على الرغم من أن هذا المصطلح أقل وضوحًا.

ستدمج وحدة المعالجة العصبية أيضًا التخزين والحوسبة من خلال الأوزان المشبكية. لذا، يمكنها التكيف أو "التعلم" بمرور الوقت، مما يؤدي إلى تحسين الكفاءة التشغيلية.

تتضمن وحدة المعالجة العصبية وحدات محددة للضرب والجمع ووظائف التنشيط وعمليات البيانات ثنائية الأبعاد وفك الضغط.

يتم استخدام وحدة الضرب والجمع المتخصصة لإجراء العمليات ذات الصلة بمعالجة تطبيقات الشبكة العصبية، مثل حساب ضرب المصفوفات والجمع، والالتفاف، وحاصل الضرب النقطي، وغيرها من الوظائف.

يمكن أن يساعد التخصص وحدة المعالجة العصبية (NPU) على إتمام عملية بحساب واحد فقط بدلاً من آلاف العمليات باستخدام أجهزة عامة. على سبيل المثال، تزعم شركة IBM أن وحدة المعالجة العصبية (NPU) يمكنها تحسين كفاءة حسابات الذكاء الاصطناعي بشكل جذري مقارنةً بوحدات معالجة الرسومات (GPUs)..

"أظهرت الاختبارات أن أداء بعض وحدات NPU أفضل من وحدة معالجة الرسوميات المماثلة بأكثر من 100 مرة، مع نفس استهلاك الطاقة."

بفضل كفاءة الطاقة هذه، تحظى وحدات المعالجة العصبية بشعبية كبيرة بين الشركات المصنعة لتثبيتها في أجهزة المستخدم، حيث يمكنها المساعدة في أداء المهام محليًا لتطبيقات الذكاء الاصطناعي التوليدية، وهو مثال على "الحوسبة الحافة". (انظر أدناه لمزيد من المعلومات حول هذا الموضوع).

يتم حاليًا استكشاف العديد من الطرق لكيفية إنشاء شرائح عصبية الشكل:

- الاستفادة من الطاقة الكهربائية الحديدية الناشئة، وهي ظاهرة لا تزال غير مفهومة بشكل جيد.

- ركيزة نشطة باستخدام الفاناديوم أو التيتانيوم.

- استخدام المقاومات الذاكرية، وهو نوع جديد من المكونات الإلكترونية، والتي يمكن أداء مهام الذكاء الاصطناعي بسرعة 1/800thمن استهلاك الطاقة الطبيعي.

Aمساعد Pو rocessing Uأحمق (وحدات XPU)

يقوم XPU بدمج وحدة المعالجة المركزية (المعالج)، ووحدة معالجة الرسومات (بطاقة الرسومات / المعالجات المتوازية)، والذاكرة في نفس الجهاز الإلكتروني.

المصدر بروأدكم

XPUs هو مصطلح واسع، يشمل العديد من الاختلافات لهذا المفهوم المتمثل في جمع كل الأجهزة في وحدات مستقلة، بما في ذلك وحدات معالجة البيانات (DPUs), وحدات معالجة البنية التحتيةو و بطاقات تسريع الوظائف (FACs).

يُنظر إلى وحدات XPU على أنها تحل مشكلة متنامية في مراكز بيانات الذكاء الاصطناعي، وهي الحاجة المتزايدة إلى الاتصال بين الوحدات الفرعية، إلى الحد الذي يصبح فيه تأخر البيانات عاملاً مهمًا في إبطاء الحوسبة، أكثر من قوة الحوسبة المتاحة.

في الأساس، تنتظر الرقائق (وحدات معالجة الرسومات، ووحدات معالجة الطاقة، ووحدات معالجة الطاقة النووية، وما إلى ذلك) البيانات بقدر ما تعمل بالفعل.

شركة Broadcom هي الشركة الرائدة في هذه التكنولوجيا (AVGO -1.02٪)، التي لقد ناقشنا ذلك بالتفصيل في تقرير استثماري مخصص.

مصفوفات البوابات القابلة للبرمجة ميدانيًا (FPGAs):

وحدات FPGA هي معالجات قابلة للبرمجة، مما يجعلها أكثر مرونة وقابلية لإعادة التكوين من الدوائر المتكاملة المخصصة (ASICs) الأكثر صلابة. يمكن تخصيص وحدات FPGA لخوارزميات ذكاء اصطناعي محددة، مما قد يوفر أداءً وكفاءة طاقة أعلى.

المصدر مختبرات المتحكمات الدقيقة

المرونة تأتي بتكلفة، فوحدات FPGA عادةً ما تكون أكثر تعقيدًا وتكلفةً وتستهلك طاقةً أكبر. مع ذلك، لا تزال أكثر كفاءةً من الأجهزة العامة.

هذا يجعلها منتجًا متخصصًا إلى حد ما، حيث تُعوّض مرونتها عيوبها. على سبيل المثال، يمكن أن تستفيد تقنيات التعلم الآلي، والرؤية الحاسوبية، ومعالجة اللغة الطبيعية من تعدد استخدامات FPGA.

ذاكرة النطاق الترددي العالي (HBM):

كانت التطورات الأكثر أهمية في الأجهزة المخصصة للذكاء الاصطناعي في مجال قوة الحوسبة، والتي كانت لفترة طويلة بمثابة نقطة الاختناق في بناء المزيد من القدرة الحاسوبية لتدريب الذكاء الاصطناعي الجديد.

مع ذلك، تحتاج هذه الأنظمة أيضًا إلى أنظمة دعم عالية الكفاءة، ومن أهمها الذاكرة. توفر ذاكرة HBM، كما يشير اسمها، نطاقًا تردديًا أعلى من ذاكرة DRAM التقليدية.

يتم ذلك عن طريق تكديس عدة شرائح ذاكرة وصول عشوائي ديناميكية (DRAM) رأسيًا وتوصيلها بفتحات سيليكون (TSVs). طُوّر الجيل الأول من ذاكرة الوصول العشوائي الديناميكية (HBM) عام ٢٠١٣.

يساعد التكديس الرأسي على توفير المساحة وتقليل المسافة المادية التي تحتاج البيانات إلى قطعها، مما يؤدي إلى تسريع نقل البيانات، وهو أمر ضروري في الحوسبة القائمة على الذكاء الاصطناعي.

تعتبر وحدات HBM أكثر تعقيدًا في التصنيع وأكثر تكلفة من وحدات DRAM، ولكن فوائد الأداء وكفاءة الطاقة غالبًا ما تبرر التكلفة الأعلى لتطبيقات الذكاء الاصطناعي.

البنية التحتية لمركز بيانات الذكاء الاصطناعي: الطاقة والتبريد والاتصال

إلى جانب الذاكرة والقدرة الحاسوبية، تُعد الأنظمة المساعدة لمراكز بيانات الذكاء الاصطناعي بالغة الأهمية. فبدونها، لا يمكن للبيانات أن تتداول بالسرعة الكافية، وقد ترتفع درجة حرارة الرقاقات، أو قد تكون الطاقة المتاحة غير كافية.

وهذا يعني، على سبيل المثال، أن أجهزة الاتصال من شركة Broadcom تستفيد أيضًا بشكل كبير من بناء مركز بيانات الذكاء الاصطناعي، كما هو الحال مع الحلول المتخصصة مثل موردي معدات التبريد، على سبيل المثال، شركة Vertiv (VRT -1.18٪) أو شنايدر إلكتريك (سو.با).

وقد يصبح إمداد الطاقة أيضًا مشكلة، وتحاول العديد من شركات التكنولوجيا العملاقة معالجة المشكلة من خلال الرهان على الطاقة النووية، مع الخطوة الأولى التي اتخذتها مايكروسوفت في عام 2024، وتبعه العديد من الآخرين منذ ذلك الحين.

بالإضافة إلى الالتزام بخفض البصمة الكربونية للذكاء الاصطناعي من قبل شركات التكنولوجيا، فإن هذا من شأنه أن يفيد بشكل كبير الشركات في قطاع الطاقة النووية أو المتجددة، مثل كاميكو (CCJ -2.15٪), جي فيرنوفا (GEV -1.34٪), الطاقة الشمسية الأولى (FSLR + 1.85٪), العصر التالي (NEE + 1.51٪) أو شركاء بروكفيلد للطاقة (BEP -0.1٪) (اتبع الروابط للحصول على تقرير عن كل شركة).

تقنيات الحوسبة الناشئة بالذكاء الاصطناعي

الاحصاء الكمية

نظرًا لأن الذكاء الاصطناعي متعطش جدًا لقوة الحوسبة، فمن المحتمل أن مستقبل الأجهزة في هذا المجال لا يتلخص في الحلول السيليكونية المتاحة حاليًا.

أحد الاحتمالات هو أن الحوسبة الكمومية يمكن استخدامها لاكتشاف الأنماط بكفاءة أكبر بكثير من الحوسبة الكلاسيكية، شيء تم استكشافه بالفعل من قبل الباحثين.

يمكن استخدام الحوسبة الكمومية ككل لحل بعض الحسابات المحددة التي تكاد تكون مستحيلة باستخدام الحوسبة الثنائية. ومن المرجح أن يُطبق هذا في نهاية المطاف على الذكاء الاصطناعي، لكن ظهور أول حواسيب كمومية تجارية لا يزال على بُعد بضع سنوات، وشبكة كمومية كبيرة أبعد من ذلك.

الضوئيات

باستخدام الضوء بدلاً من الإلكترونات لنقل البيانات، يمكن أن تكون الفوتونيات أسرع بكثير من الأجهزة الإلكترونية.

نظرًا لأن أجهزة الكمبيوتر الكمومية تحمل عادةً بيانات كمية مع فوتونات متشابكة، فهناك أيضًا قدر كبير من التداخل بين الحوسبة الكمومية والفوتونيات، تم الإعلان بالفعل عن أول شريحة فوتونية كمية مزدوجة.

أورجانويدز

وبما أن معظم الذكاء الاصطناعي يكرر في أجهزة الكمبيوتر عمل الشبكات العصبية في الدماغ، فإن بعض الباحثين يتساءلون عما إذا كان بإمكاننا بدلاً من ذلك استخدام ... خلايا الدماغ الفعلية.

هذه فكرة مثيرة للاهتمام، خاصة وأن قد تشير بعض الأبحاث إلى أن الدماغ هو في الواقع حاسوب كمي عضوي.

يُطلق على هذا النوع من "الحاسوب" اسم "العضويات"، ويتكون أساسًا من خلايا عصبية تُزرع في مختبر على شريحة حاسوبية. ثم تُنظم الخلايا العصبية تشعباتها واتصالاتها ذاتيًا استجابةً لمحفز الشريحة.

هذه التكنولوجيا لا تزال جديدة وتعتمد على الطباعة الحيوية ثلاثية الأبعاد.

أخرى

لقد استكشفنا بدائل أخرى للحوسبة السيليكونية في "أفضل 10 شركات حوسبة غير سيليكونية"، مثل ثاني أكسيد الفاناديوم، أو الجرافين، أو بوابات الأكسدة والاختزال، أو المواد العضوية.

يَعِد كلٌّ منهما بأن يكون أسرع بكثير أو أقل استهلاكًا للطاقة من الحوسبة التقليدية القائمة على السيليكون. ومع ذلك، فهي لا تزال حديثة العهد نسبيًا، ومن غير المرجح أن تُحدث ثورةً في مجال الذكاء الاصطناعي على نطاق تجاري، على الأقل خلال السنوات الخمس إلى العشر القادمة.

الذكاء الاصطناعي السحابي والذكاء الاصطناعي على الحافة: اتجاهات إمكانية الوصول

سحابة AI

بما أن أقوى أنظمة الذكاء الاصطناعي تُصنّعها شركات تقنية كبرى، فإن الوصول إليها غالبًا ما يكون متاحًا عبر السحابة. وينطبق الأمر نفسه على الوصول إلى الأجهزة المتخصصة بالذكاء الاصطناعي.

زعيم هذا الاتجاه هو كورويف (CRCW -6.25٪)، وهي شركة انتقلت من توفير الخدمات السحابية إلى تعدين العملات المشفرة باستخدام وحدات معالجة الرسوميات، إلى توفير الحوسبة بالذكاء الاصطناعي عند الطلب اليوم.

هذا جعل CoreWeave شريكًا رئيسيًا لشركات الذكاء الاصطناعي الناشئة التي تحاول التنافس مع عمالقة التكنولوجيا، مثل انعكاس الذكاء الاصطناعي ولها مجموعة وحدات معالجة رسومية بقيمة 1.3 مليار دولار، بتمويل من جولة تمويلية جديدة.

"قبل شهرين، ربما لم تكن الشركة موجودة، والآن قد يكون لديها 500 مليون دولار من تمويل رأس المال الاستثماري.

"والأمر الأكثر أهمية بالنسبة لهم هو تأمين الوصول إلى الحوسبة؛ فلا يمكنهم إطلاق منتجاتهم أو إطلاق أعمالهم حتى يحصلوا عليها".

مع تزايد حذر اللاعبين في مجال أجهزة الذكاء الاصطناعي من شركات التكنولوجيا الكبرى التي تنتج وحدات معالجة الرسوميات ووحدات معالجة الرسومات ووحدات معالجة الرسومات XPU وما إلى ذلك الخاصة بها وتتطور من عملاء إلى منافسين، فمن المرجح أن تحصل شركات مثل CoreWeave على أولوية الوصول إلى أحدث إصدارات الأجهزة من Nvidia وغيرها.

ومن المرجح أن يكون نموذج الأعمال هذا مهمًا بشكل خاص لتدريب الذكاء الاصطناعي، والذي يتطلب قدرة حوسبة أكبر بكثير من مجرد استخدام الذكاء الاصطناعي المدرب بالفعل.

الحوسبة الحافة وأجهزة الكمبيوتر ذات الذكاء الاصطناعي

هناك حالة أخرى من حالات الحوسبة القائمة على الذكاء الاصطناعي والتي تتطور بسرعة وهي الحاجة إلى إجراء حوسبة أنظمة الذكاء الاصطناعي في الموقع، في أقرب مكان ممكن من مواقف الحياة الواقعية.

يعد هذا أمرًا ضروريًا للأنظمة التي قد لا تتحمل الانفصال عن الذكاء الاصطناعي في حالة فشل الاتصال، أو عندما يكون زمن الوصول ذهابًا وإيابًا مع السحابة بطيئًا للغاية.

ومن الأمثلة الجيدة على ذلك السيارات ذاتية القيادة، التي من المتوقع أن تتمكن من فهم بيئتها دون اتصال بالإنترنت.

يُطلق على هذا النوع من الحسابات اسم الحوسبة الحافة، وهو يستفيد بشكل كبير من الأجهزة الأكثر كفاءة والأقل استهلاكًا للطاقة.

يمكن أن يؤدي ذلك إلى زيادة موثوقية الذكاء الاصطناعي، ومع تزايد كفاءة النماذج، وهو ما يتضح من خلال القفزة التي أحرزتها DeepSeek، فقد يصبح نموذجًا أكثر انتشارًا لنشر الذكاء الاصطناعي في المستقبل.

لنفس السبب، أجهزة الكمبيوتر التي تعمل بالذكاء الاصطناعي مثل الذي أطلقته شركة Nvidia مؤخرًاقد يكون ذلك كافياً على المدى الطويل لتشغيل العديد من تطبيقات الذكاء الاصطناعي محليًا، مما يزيد من الخصوصية والأمان مقارنة بتطبيقات الذكاء الاصطناعي المتصلة دائمًا بالسحابة.

الخاتمة

لطالما ارتبطت أجهزة الذكاء الاصطناعي بوحدات معالجة الرسومات (GPUs)، إذ كانت بطاقات الرسومات أكثر كفاءةً في تدريب الذكاء الاصطناعي مقارنةً بأنواع أخرى من الأجهزة، مثل وحدات المعالجة المركزية (CPUs). وقد أسهم هذا في تحقيق ثروة طائلة لشركة إنفيديا والعديد من مساهميها الأوائل.

من المرجح أن تحافظ وحدات معالجة الرسومات، وخاصةً "وحدات معالجة الرسومات الفائقة" المُركزة على الذكاء الاصطناعي، على أهميتها في بناء مراكز بيانات الذكاء الاصطناعي. لكنها ستتطور لتصبح مجرد جزء من أنظمة متزايدة التعقيد والتخصص.

سيتم إرسال عمليات المحول إلى وحدات المعالجة الحرارية (TPUs)، وهي شبكات عصبية مخصصة لـNPP، ويتم إرسال المهام المتكررة إلى ASICs مخصصة أو FPGAs معاد تكوينها.

وفي الوقت نفسه، ستعمل الذاكرة ذات النطاق الترددي العالي، وموصلات الاتصالات المتقدمة، والتبريد فائق الكفاءة على إبقاء جميع الوظائف المساعدة حول نواة الحوسبة قيد التشغيل.

بالنسبة للحوسبة الحافة والذكاء الاصطناعي الأصغر من LLMs الضخمة، من المرجح أن يستخدم العلماء والسيارات ذاتية القيادة والمستخدمون المهتمون بالخصوصية أو الرقابة الحوسبة المحلية، والتي ربما تعمل بواسطة وحدات معالجة XPU الكل في واحد، ربما مع نماذج الذكاء الاصطناعي مفتوحة المصدر.

ومن المؤكد أن الأرباح من بيع "المعاول والمجارف" الخاصة بأجهزة الذكاء الاصطناعي في سباق الذهب نحو الذكاء الاصطناعي لا تزال بعيدة كل البعد عن الانتهاء.

بعد فترة من هيمنة شركة Nvidia، قد يرغب المستثمرون في تنويع المخاطر من خلال نشر محفظة أجهزة الذكاء الاصطناعي الخاصة بهم إلى تصميمات أخرى، وربما حتى شركات المرافق الكهربائية التي ستوفر جيجاواط الثمينة لتشغيل مراكز بيانات الذكاء الاصطناعي الكبيرة والضخمة بشكل متزايد في العالم.